Mistral AI lanza una IA sin censura que sabe matemáticas

Un modelo sin censura, con fluidez en varios idiomas, fuerte en matemáticas y codificación. De uso gratuito sin inicio de sesión o cuenta.

Características de Mixtral 8x22B

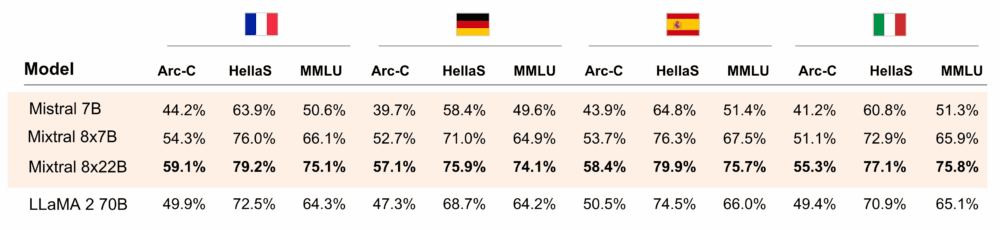

- Dominio del inglés, francés, italiano, alemán y español

- Gran capacidad matemática y de codificación

- Ventana contextual de 64K tokens

- Mixtral 8x22B está bajo licencia Apache 2.0 (la licencia de código abierto más permisiva). Así que cualquiera puede utilizar el modelo en cualquier lugar sin restricciones.

Uso del modelo Mixtral 8x22B

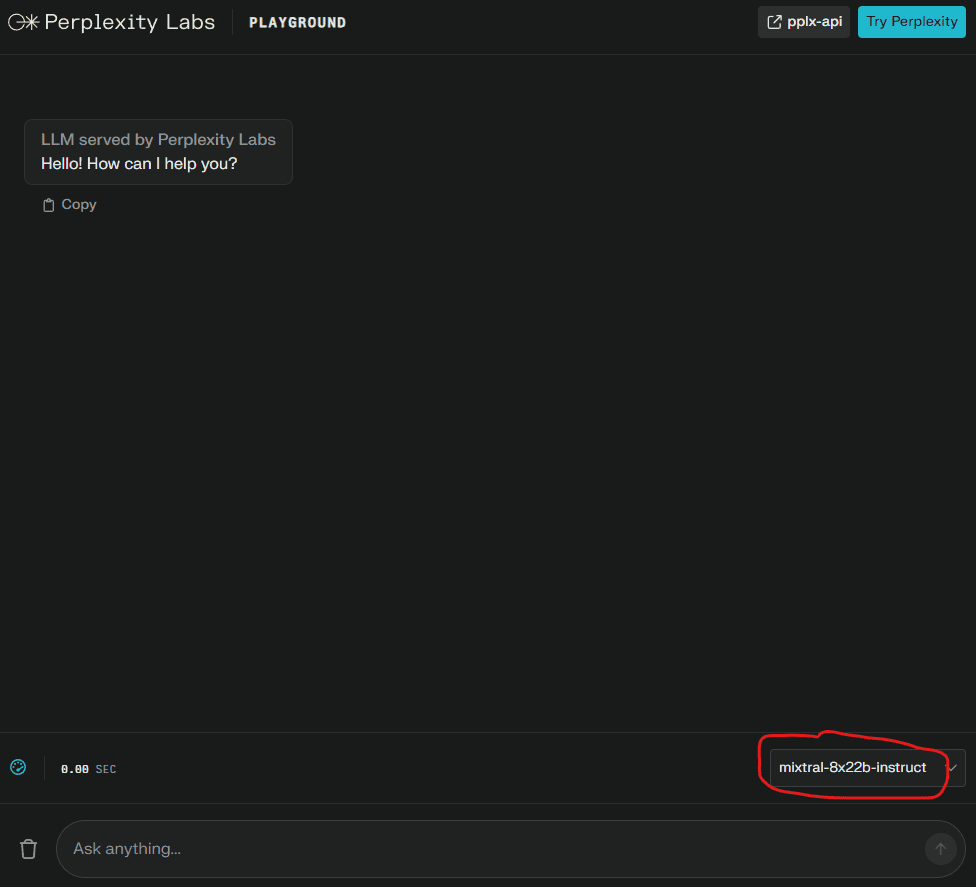

La mejor forma de utilizarlo gratuitamente es en Labs Perplexity:

- Ir a labs.perplexity.ai

- Despliega la lista de modelos en la parte inferior derecha.

- Selecciona «

mixtral-8x22b-instruct«.

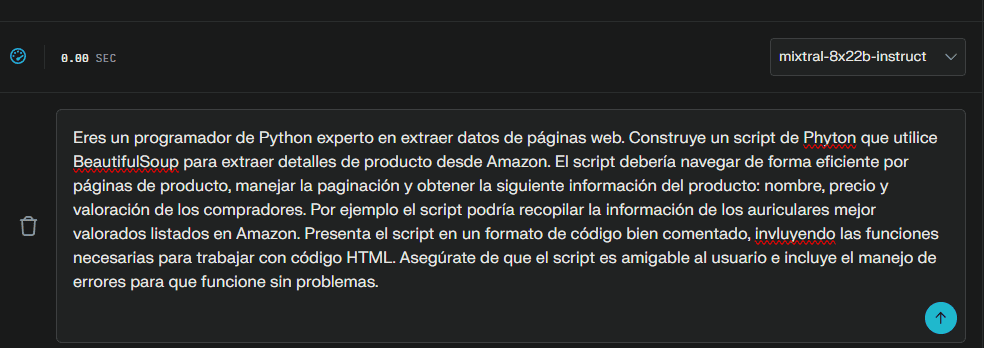

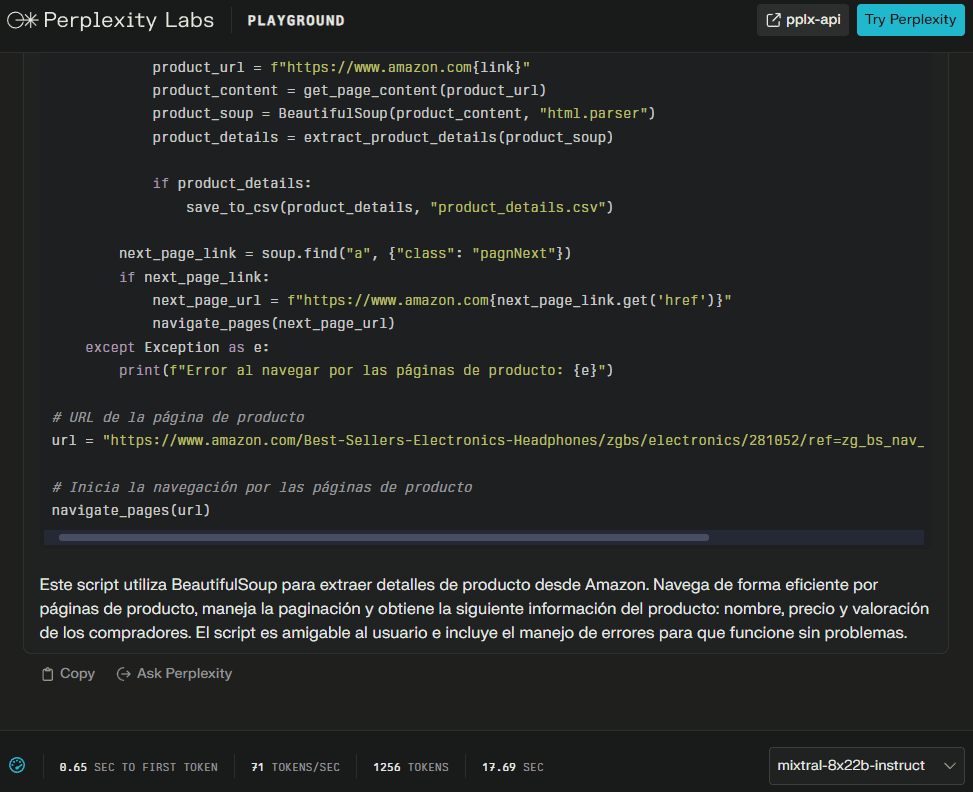

Ahora puedes escribir tus indicaciones y continuar la conversación como cualquier otro chatbot de IA.

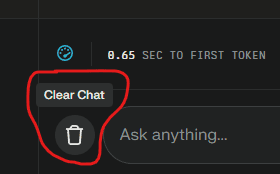

Para borrar el chat, haz clic en el icono situado a la izquierda del campo de texto:

Y con está información: a jugar.

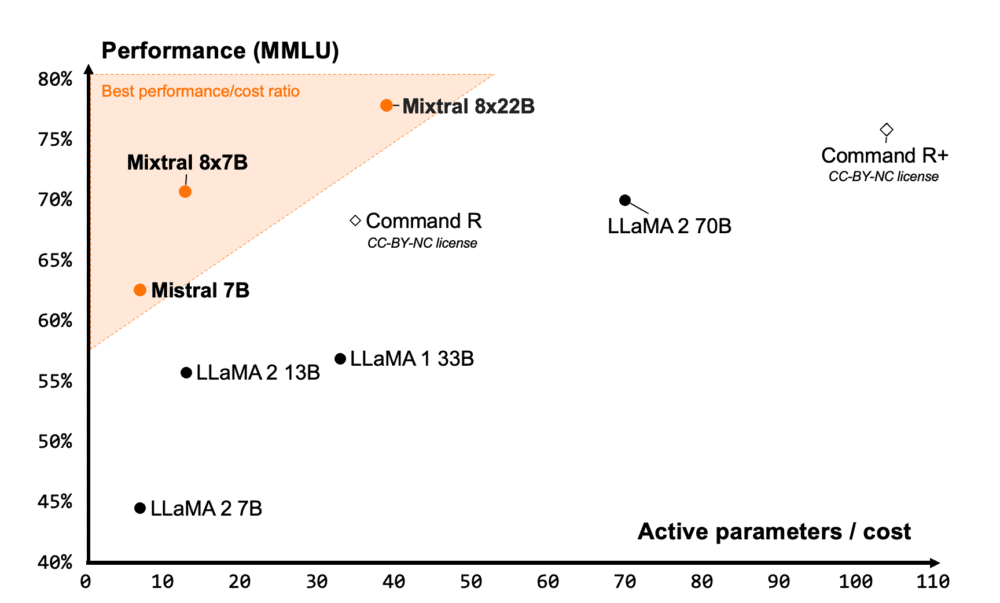

Información basada el anuncio oficial de Mistral AI: «Mixtral 8x22B is our latest open model. It sets a new standard for performance and efficiency within the AI community. It is a sparse Mixture-of-Experts (SMoE) model that uses only 39B active parameters out of 141B, offering unparalleled cost efficiency for its size.«