Ejecuta IA de forma local con NVIDIA Digits

Mientras que Apple ha estado posicionando los chips M4 para la ejecución local de IA, NVIDIA acaba de rebajar su precio de forma masiva.

Un cluster de ordenadores personales del Proyecto Digits va a ser la forma más asequible de ejecutar localmente los LLM.

El titular de 1 petaflop parece una hipérbole comercial, pero por lo demás se trata de un gran negocio:

- Proyecto Digits: 128GB @ 512GB/s, 250 TFLOPS (fp16), 3.000 dólares

- M4 Pro Mac Mini: 64 GB a 273 GB/s, 17 TFLOPS (fp16), 2.200 dólares

- M4 Max MacBook Pro: 128 GB a 546 GB/s, 34 TFLOPS (fp16), 4.700 dólares

El Project Digits tiene el doble de ancho de banda de memoria que el M4 Pro y 14 veces más capacidad de cálculo.

Project Digits puede ejecutar Llama 3.3 70B (fp8) a 8 tok/seg (velocidad de lectura).

La inferencia de solicitud única (batch_size=1) se ve limitada por la memoria y el ancho de banda de la memoria. Esta fue siempre la limitación con la RTX 4090 y la razón por la que un PC de juegos no puede competir en tokens por segundo a batch_size=1. El modelo completo no cabe en una RTX 4090 (24 GB), por lo que debe cargarse en la GPU desde la RAM del sistema, con el cuello de botella que supone el enlace PCIe 4.0 de 64 GB/s de la GPU.

También se empezarán a ver construcciones con varias GPU 5070. La actualización a PCIe 5.0 significa que una máquina 2 x 5070 podría soportar un ancho de banda de 256 GB/s desde la RAM del sistema a la GPU. Estimo que este modelo costará unos 6.000 dólares en total (la compatibilidad total con PCIe 5.0 x16/x16 es cara), lo que equivale al coste de dos PC Project Digits.

Felicidades NVIDIA: acabáis de encontrar un nuevo mercado.

NVIDIA pone la IA en los escritorios y al alcance de los desarrolladores

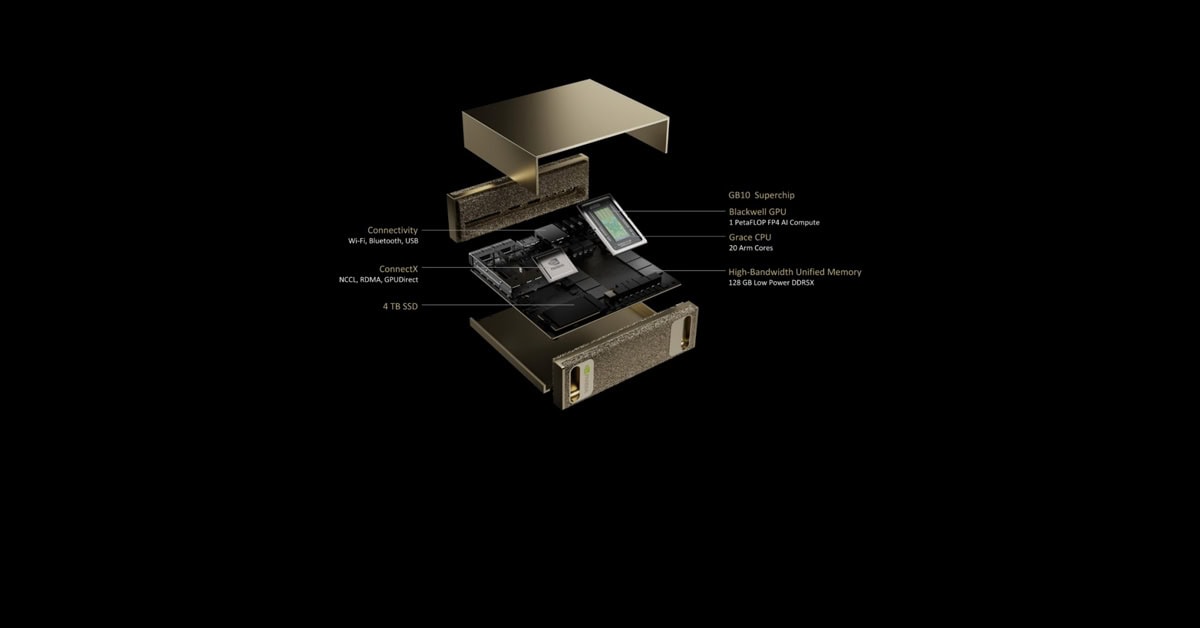

El proyecto DIGITS de NVIDIA, con el nuevo superchip GB10, se presenta como el superordenador de IA más pequeño del mundo capaz de ejecutar modelos de 200.000 parámetros.

Project DIGITS incorpora el nuevo superchip NVIDIA GB10 Grace Blackwell, que ofrece un petaflop de rendimiento computacional de IA para la creación de prototipos, la puesta a punto y la ejecución de grandes modelos de IA.

Con Project DIGITS, los usuarios pueden desarrollar y ejecutar inferencia sobre modelos utilizando su propio sistema de escritorio y, a continuación, implantar los modelos sin problemas en infraestructuras aceleradas de nube o centros de datos.

«La IA se generalizará en todas las aplicaciones de todos los sectores. Con Project DIGITS, el superchip Grace Blackwell llega a millones de desarrolladores», afirma Jensen Huang, fundador y CEO de NVIDIA. «Poner un superordenador de IA en los escritorios de cada científico de datos, investigador de IA y estudiante les capacita para participar y dar forma a la era de la IA».

El superchip GB10 proporciona un petaflop de rendimiento de IA con eficiencia energética

El GB10 Superchip es un sistema en un chip (SoC) basado en la arquitectura NVIDIA Grace Blackwell y proporciona hasta 1 petaflop de rendimiento de IA con precisión FP4.

GB10 incorpora una GPU NVIDIA Blackwell con núcleos CUDA® de última generación y Tensor Cores de quinta generación, conectada a través de la interconexión chip a chip NVLink®-C2C a una CPU NVIDIA Grace™ de alto rendimiento, que incluye 20 núcleos de bajo consumo construidos con la arquitectura Arm. MediaTek, líder del mercado en el diseño de SoC basados en Arm, ha colaborado en el diseño del GB10, contribuyendo a su eficiencia energética, rendimiento y conectividad, los mejores de su categoría.

El GB10 Superchip permite a Project DIGITS ofrecer un potente rendimiento utilizando únicamente una toma de corriente eléctrica estándar. Cada Project DIGITS cuenta con 128 GB de memoria unificada y coherente y hasta 4 TB de almacenamiento NVMe. Con el superordenador, los desarrolladores pueden ejecutar modelos de lenguaje de gran tamaño de hasta 200.000 millones de parámetros para potenciar la innovación en IA. Además, utilizando la red NVIDIA ConnectX®, dos superordenadores de IA del Proyecto DIGITS pueden conectarse para ejecutar modelos de hasta 405 mil millones de parámetros.

Con la arquitectura Grace Blackwell, las empresas y los investigadores pueden crear prototipos, afinar y probar modelos en sistemas Project DIGITS locales que ejecutan NVIDIA DGX OS basado en Linux, y luego implementarlos sin problemas en NVIDIA DGX Cloud™, instancias aceleradas en la nube o infraestructura de centros de datos.

Esto permite a los desarrolladores crear prototipos de IA en Project DIGITS y luego escalarlos en la nube o en la infraestructura del centro de datos, utilizando la misma arquitectura Grace Blackwell y la plataforma de software NVIDIA AI Enterprise.

Los usuarios de Project DIGITS pueden acceder a una amplia biblioteca de software de IA de NVIDIA para experimentar y crear prototipos, lo que incluye kits de desarrollo de software, herramientas de orquestación, frameworks y modelos disponibles en el catálogo de NVIDIA NGC y en el portal para desarrolladores de NVIDIA. Los desarrolladores pueden ajustar los modelos con el marco NVIDIA NeMo™, acelerar la ciencia de datos con las librerías NVIDIA RAPIDS™ y ejecutar marcos comunes como PyTorch, Python y los cuadernos Jupyter.

Para crear aplicaciones de IA agéntica, los usuarios también pueden aprovechar los microservicios NVIDIA Blueprints y NVIDIA NIM™, que están disponibles para investigación, desarrollo y pruebas a través del Programa para desarrolladores de NVIDIA. Cuando las aplicaciones de IA están listas para pasar de la experimentación a los entornos de producción, la licencia NVIDIA AI Enterprise proporciona seguridad de nivel empresarial, soporte y versiones de producto del software NVIDIA AI.

Disponible en mayo de 2025, a partir de 3.000 dólares. Un hito en la democratización del desarrollo de IA al llevar la computación de clase de centro de datos a investigadores individuales, desarrolladores y estudiantes.

Esto es lo que lo hace especial

Hardware:

- Nuevo superchip Grace Blackwell GB10

- 1 petaflop de rendimiento de IA con precisión FP4.

- CPU Grace con 20 núcleos ARM (en colaboración con MediaTek)

- Núcleos CUDA de última generación y núcleos tensoriales de 5ª generación

- 128 GB de memoria LPDDR5 unificada

- Hasta 4 TB de almacenamiento NVMe

- Redes NVIDIA ConnectX

Capacidades:

- Ejecuta modelos de IA de hasta 200B de parámetros

- Enlaza dos unidades para manejar modelos de 405B parámetros

- Funciona con alimentación de pared estándar

- Sistema operativo NVIDIA DGX basado en Linux

- Pila completa de software de IA de NVIDIA preinstalada

Diseñado para:

- Prototipos de modelos de IA

- Ajuste fino

- Cargas de trabajo de inferencia

- Ciencia de datos

- Desarrollo de aplicaciones Edge

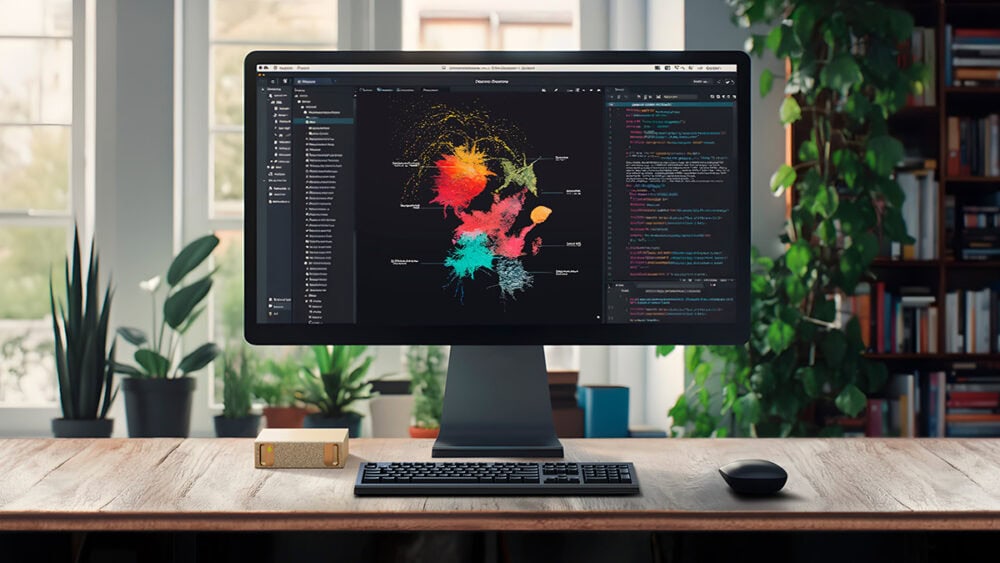

Compatibilidad de EXO con los clusters PCs Project Digits

EXO Labs, además de funcionar en los clusters Mac con M4, también lo hará desde su lanzamiento en los clusters PCs Project Digits.

Requisitos de Exo Labs

El único requisito para ejecutar exo es tener suficiente memoria en todos los dispositivos para que quepa todo el modelo en la memoria. Por ejemplo, si está ejecutando Llama 3.1 8B (fp16), necesita 16 GB de memoria en todos los dispositivos. Cualquiera de las siguientes configuraciones funcionaría, ya que cada una de ellas tiene más de 16 GB de memoria en total:

- 2 MacBook Air M3 de 8 GB

- 1 portátil NVIDIA RTX 4070 Ti de 16 GB

- 2 x Raspberry Pi 400 con 4 GB de RAM cada una (funcionando con CPU) + 1 x Mac Mini de 8 GB

exo está diseñado para funcionar en dispositivos con capacidades heterogéneas. Por ejemplo, puedes tener algunos dispositivos con GPU potentes y otros con GPU integradas o incluso CPU. La adición de dispositivos menos capaces ralentizará la latencia de inferencia individual, pero aumentará el rendimiento global del clúster.

Información basada en la información oficial de NVIDIA del Project Digits y en la publicación en X/Twitter de Alex Cheema – e/acc del equipo de Exo Labs. Tienes el Gitub de Exo Labs disponible aquí («exo: gestiona tu propio clúster de IA en casa con dispositivos cotidianos»).