Microsoft se alía con Nvidia para acelerar la IA en las empresas

Microsoft será una de las primeras organizaciones en introducir en Azure la potencia de NVIDIA Grace Blackwell GB200.

Azure se beneficiará de la potencia de NVIDIA Grace Blackwell GB200 y la red InfiniBand avanzada NVIDIA Quantum-X800, con el fin de proporcionar modelos de base de trillones de parámetros de última generación para el procesamiento del lenguaje natural, la visión por computador y el reconocimiento del habla, entre otros.

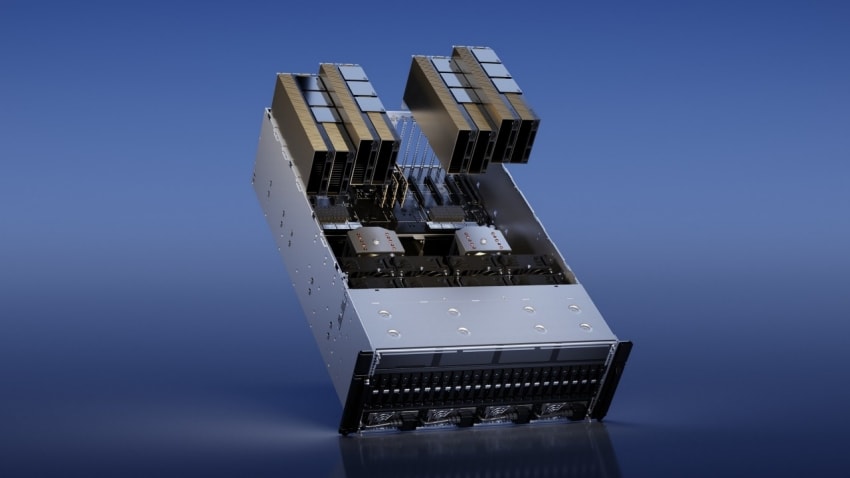

¿Qué es NVIDIA GB200?

NVIDIA DGX GB200 es una infraestructura de IA a escala con refrigeración líquida que puede escalarse hasta alcanzar miles de superchips NVIDIA GB200 Grace Blackwell. Se ha creado específicamente para el entrenamiento y la inferencia de modelos de IA generativa de billones de parámetros con un plano de control inteligente para ofrecer un tiempo de actividad constante para las implementaciones de IA más exigentes.

El nuevo DGX SuperPOD, dotado de una nueva arquitectura de alta eficiencia y refrigeración líquida, está construido con sistemas NVIDIA DGX™ GB200 y proporciona 11,5 exaflops de supercomputación de IA a precisión FP4 y 240 terabytes de memoria rápida, cifra que se amplía con bastidores adicionales.

Cada sistema DGX GB200 cuenta con 36 NVIDIA GB200 Superchips -que incluyen 36 CPU NVIDIA Grace y 72 GPU NVIDIA Blackwell- conectados como un superordenador a través de NVIDIA NVLink® de quinta generación. Los Superchips GB200 proporcionan hasta 30 veces más rendimiento que la GPU NVIDIA H100 Tensor Core para grandes cargas de trabajo de inferencia de modelos lingüísticos.

Los superordenadores de IA NVIDIA DGX son las fábricas de la revolución industrial de la IA. El nuevo DGX SuperPOD combina los últimos avances en computación acelerada, redes y software de NVIDIA para permitir a cada empresa, industria y país refinar y generar su propia IA.

Jensen Huang, fundador y CEO de NVIDIA

El DGX SuperPOD impulsado por Grace Blackwell cuenta con ocho o más sistemas DGX GB200 y puede escalar hasta decenas de miles de GB200 Superchips conectados a través de NVIDIA Quantum InfiniBand. Para disponer de un espacio de memoria compartida masivo que alimente los modelos de IA de última generación, los clientes pueden implantar una configuración que conecte las 576 GPU Blackwell en ocho sistemas DGX GB200 conectados a través de NVLink.

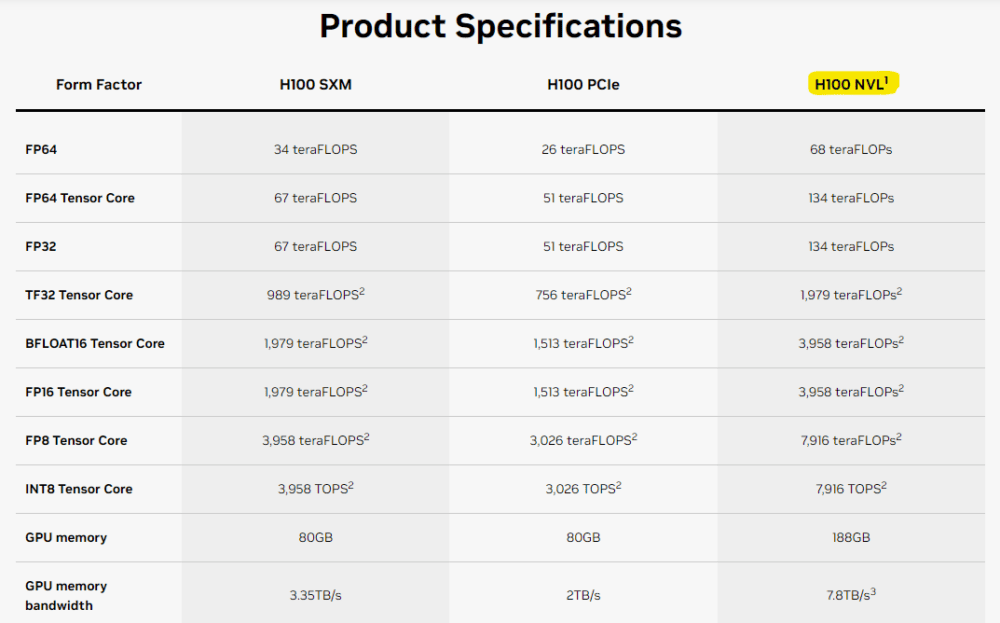

Máquina virtual Azure NC H100 V5

Microsoft también anuncia la disponibilidad general de su máquina virtual (VM) Azure NC H100 v5 basada en la plataforma NVIDIA H100 NVL.

Diseñada para entrenamiento e inferencias de rango medio, la serie NC de máquinas virtuales ofrece a los clientes dos clases de VM de una a dos GPUs NVIDIA H100 94GB PCIe Tensor Core y soporta la tecnología NVIDIA Multi-Instance GPU (MIG), que permite a los clientes particionar cada GPU en hasta siete instancias, proporcionando flexibilidad y escalabilidad para diversas cargas de trabajo de IA.

Información basada la publicación de la sala de prensa de Microsoft «Microsoft and NVIDIA announce major integrations to accelerate generative AI for enterprises everywhere» y la información oficial de NVIDIA sobre VIDIA GB200 Grace Blackwell Superchips: «NVIDIA Launches Blackwell-Powered DGX SuperPOD for Generative AI Supercomputing at Trillion-Parameter Scale» & «NVIDIA DGX SuperPOD with DGX GB200 Systems«.