Buenas prácticas de seguridad para aplicaciones OpenAI en Azure

Buenas prácticas, desafíos de seguridad y acciones que deben ser abordadas por los desarrolladores y administradores de las aplicaciones GenAI (OpenAI) en Azure.

Las aplicaciones GenAI son aquellas que utilizan grandes modelos lingüísticos (LLM) para generar textos en lenguaje natural o realizar tareas de comprensión del lenguaje natural. Los LLM son herramientas potentes que pueden permitir diversos escenarios, como la creación de contenidos, el resumen, la traducción, la respuesta a preguntas y los agentes conversacionales. Sin embargo, los LLM también plantean importantes retos de seguridad que deben ser abordados por los desarrolladores y administradores de aplicaciones GenAI. Estos retos incluyen:

- Proteger la confidencialidad e integridad de los datos utilizados para entrenar y consultar los LLM.

- Garantizar la disponibilidad y fiabilidad de los LLM y sus servicios.

- Impedir el mal uso o abuso de los LLM por parte de agentes malintencionados o usuarios no deseados.

- Supervisar y auditar los resultados y comportamientos de los LLM para comprobar su calidad, precisión y cumplimiento.

- Gestionar las implicaciones éticas y sociales de los resultados e impactos de los LLM.

Aquí se proporciona una visión general de las mejores prácticas de seguridad para aplicaciones GenAI en Azure, centrándose en Azure OpenAI pero describiendo también la seguridad relacionada con otros LLMs que pueden utilizarse dentro de Azure. Azure OpenAI es un servicio basado en la nube que permite a los usuarios acceder e interactuar con el modelo GPT-3 de OpenAI, uno de los LLM más avanzados disponibles en la actualidad. Otros LLM que se pueden utilizar dentro de Azure incluyen los servicios cognitivos de Microsoft, como Text Analytics, Translator y QnA Maker, así como LLM personalizados que se pueden construir y desplegar utilizando Azure Machine Learning.

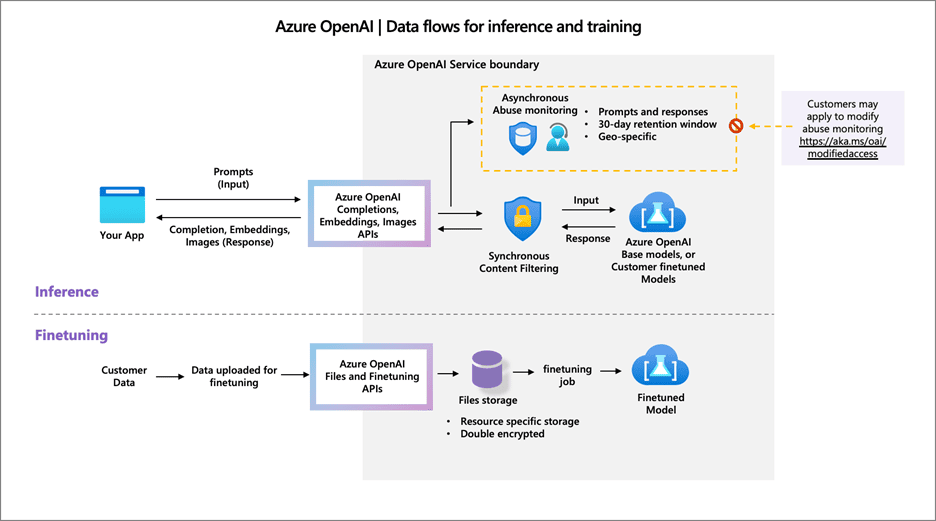

¿Cómo procesa los datos el servicio Azure OpenAI?

El enfoque de Azure OpenAI para el almacenamiento y procesamiento de datos se basa en fundamentos sólidos y seguros. Los datos de los usuarios están protegidos contra el acceso no autorizado, garantizando la privacidad y la seguridad de acuerdo con las normas de protección de datos de Microsoft.

En cuanto al uso de los datos, los principios son sencillos. La información que proporcionas, junto con las respuestas de la IA -tus datos- siguen siendo tuyos. Microsoft no utiliza estos datos para mejorar tus propias ofertas de IA. Se mantienen privados a menos que decidas utilizarlos para entrenar modelos de IA personalizados.

En cuanto a los tipos de datos procesados, Azure OpenAI procesa tus datos de entrada, es decir, las preguntas y las consiguientes respuestas generadas por la IA. También procesa los datos enviados con el fin de entrenar modelos de IA personalizados.

La capacidad de generación de contenidos del servicio viene acompañada de un compromiso con la seguridad. Las entradas se procesan cuidadosamente para producir respuestas, y existen filtros de contenidos para evitar la generación de contenidos problemáticos.

La personalización de modelos es una característica del servicio que se maneja con cuidado. Puedes entrenar los modelos de Azure OpenAI con tus datos, sabiendo que permanecen seguros y sólo para tu uso.

Para evitar abusos, Azure OpenAI viene equipado con sólidos sistemas de filtrado y supervisión de contenidos. De este modo se garantiza que la generación de contenidos cumple las directrices y que no se cuela nada perjudicial.

En los casos en los que es necesaria la revisión humana, Microsoft garantiza el mantenimiento de altos estándares de privacidad. Si existen preocupaciones particulares sobre la privacidad, se puede solicitar que una revisión se gestione de forma diferente.

Azure OpenAI pretende ofrecer capacidades avanzadas de IA al tiempo que mantiene los datos de los usuarios seguros y privados.

Privacidad y seguridad

En el contexto de los servicios Azure OpenAI, el debate en torno a la «privacidad» de los datos frente a la «seguridad» a menudo se refiere a la naturaleza distinta pero superpuesta de estos conceptos. Exploremos lo que implica cada uno y el papel que desempeña el principio de responsabilidad compartida.

La privacidad en Azure OpenAI se refiere a cómo se gestionan los datos de los usuarios en términos de acceso y uso. Garantiza que datos como entradas, interacciones y salidas se utilicen de forma que se respete la confidencialidad del cliente. El protocolo de privacidad de Azure OpenAI dicta que Microsoft no ve ni utiliza estos datos para sus propios fines, a menos que se permita explícitamente para servicios como el ajuste de modelos. Las medidas de privacidad tienen que ver con el control y el manejo ético de los datos.

La seguridad, por su parte, consiste en proteger los datos de accesos no autorizados, infracciones y otras formas de peligro. Azure OpenAI emplea una serie de medidas de seguridad, como el cifrado en tránsito y en reposo, para proteger los datos frente a las amenazas. La infraestructura de Microsoft proporciona un entorno seguro diseñado para proteger sus datos de los riesgos de seguridad.

El principio de responsabilidad compartida pone de relieve que la seguridad en la nube es una vía de doble sentido. Mientras que Microsoft garantiza la seguridad de los servicios Azure OpenAI, es responsabilidad del cliente asegurar su parte de la interacción.

Por ejemplo, Microsoft se encarga de:

- Proteger la infraestructura de Azure

- Asegurarse de que los servicios Azure OpenAI son seguros por defecto

- Proporcionar capacidades de gestión de identidad y acceso

Sin embargo, los clientes son responsables de:

- Establecer controles de acceso y permisos adecuados para su uso de Azure OpenAI

- Proteger sus credenciales de Azure y gestionar el acceso a su suscripción de Azure

- Garantizar que las medidas de seguridad en torno a sus aplicaciones sean adecuadas, incluida la validación de entrada, la lógica de aplicación segura y el manejo adecuado de los resultados de Azure OpenAI.

Esta responsabilidad compartida garantiza que, si bien Microsoft proporciona un nivel básico de seguridad, los clientes pueden y deben adaptar los controles de seguridad adicionales en función de las necesidades específicas y la sensibilidad de sus datos. En términos sencillos, piensa que Microsoft proporciona un apartamento seguro mientras que los clientes deben cerrar sus puertas y decidir quién recibe las llaves.

Los clientes deben considerar cuidadosamente su postura de seguridad en torno a las aplicaciones y los datos que gestionan para complementar las sólidas capacidades de seguridad de Microsoft. Esto podría implicar la aplicación de medidas de seguridad de red adicionales, garantizando prácticas de codificación seguras y auditando regularmente el acceso y el uso para alinearse con sus requisitos de seguridad particulares.

Al comprender tanto las disposiciones de privacidad como de seguridad de Azure OpenAI y participar activamente en el modelo de responsabilidad compartida, los clientes pueden aprovechar el poder de la IA preservando tanto la integridad como la confidencialidad de sus datos.

Mejores prácticas de seguridad para aplicaciones GenAI en Azure

Seguir un enfoque por capas basado en el marco Zero Trust proporciona una estrategia de seguridad robusta para aplicaciones LLM (Large Language Models), como las que ofrece Azure OpenAI.

Zero Trust es una estrategia global que debería aplicarse en todos los dominios de seguridad; asume que podría existir una amenaza tanto en el interior como en el exterior. Por lo tanto, cada solicitud de acceso, independientemente de dónde se origine, debe estar totalmente autenticada, autorizada y cifrada antes de que se conceda el acceso.

Al integrar estas prácticas en una estrategia cohesiva, los clientes de Azure pueden crear un entorno seguro para sus aplicaciones GenAI. Además, a medida que evolucionan las amenazas, es esencial evaluar y adaptar continuamente estas medidas de seguridad para mantener una defensa sólida contra posibles ciberamenazas.

A continuación, le mostramos cómo podría implementar las mejores prácticas de seguridad en diferentes dominios:

Seguridad de datos

La seguridad de los datos se refiere a la protección de los datos utilizados para entrenar y consultar los LLM, así como de los datos generados por los LLM. La seguridad de los datos implica garantizar la confidencialidad, integridad y disponibilidad de los datos, así como cumplir con los requisitos normativos y de privacidad de los datos. Algunas de las mejores prácticas de seguridad de datos para aplicaciones GenAI en Azure son:

- Clasificación y sensibilidad de los datos: Clasifica y etiqueta tus datos en función de su nivel de sensibilidad. Identifique y proteje los datos sensibles, como la información personal identificable (PII), los datos financieros o la información propietaria, con el cifrado y los controles de acceso adecuados.

- Para aplicar la clasificación y el etiquetado de forma coherente con la gobernanza, Microsoft Purview es una herramienta perfecta. Permite la categorización automática y la gobernanza de datos en diversas plataformas. Con Purview, los usuarios pueden escanear sus fuentes de datos, clasificar y etiquetar activos, aplicar etiquetas de sensibilidad y supervisar cómo se utilizan los datos, garantizando que las bases sobre las que opera la IA Generativa sean seguras y resistentes.

- Por el momento no existe una integración directa entre Purview y AI Search, pero si dispone de datos que residen en otras fuentes, puedes utilizar Purview para clasificarlos antes de generar incrustaciones y almacenarlos en AI Search.

- Cifrado en reposo y en tránsito: En cuanto a la implementación del cifrado para los datos utilizados con Retrieval-Augmented Generation (RAG) en Azure OpenAI, es importante garantizar la seguridad de sus datos tanto en reposo como en tránsito. Para los servicios de Azure, los datos en reposo se cifran de forma segura mediante Azure Storage Service Encryption y Azure Disk Encryption incorporados, y tienes la opción de gestionar tus claves de cifrado en Azure Key Vault. En cuanto a los datos en tránsito, están protegidos mediante Transport Layer Security (TLS) y el uso obligatorio de protocolos de comunicación seguros. Según tus requisitos específicos, asegúrate de que los servicios en los que se recuperan o almacenan los datos cumplen tus requisitos de cifrado. Si utilizas servicios de Azure como Azure Cognitive Search, vienen con controles de seguridad inherentes; además, puedes aprovechar funciones avanzadas como las claves gestionadas por el cliente para obtener un control adicional. En el caso de que los servicios externos estén interconectados con Azure, verifica que adopten estándares de cifrado equivalentes para mantener una seguridad sólida en todo el ciclo de vida de sus datos.

- Controles de acceso basados en roles (Role-Based Access Controls · RBAC): Utiliza RBAC para gestionar el acceso a los datos almacenados en los servicios Azure. Asigna los permisos adecuados a los usuarios y restrinje el acceso en función de tus funciones y responsabilidades. Revisa y actualiza periódicamente los controles de acceso para adaptarlos a las necesidades cambiantes.

- Enmascaramiento de datos: Implementa técnicas de enmascaramiento o redacción de datos para ocultar datos confidenciales o sustituirlos por valores ofuscados en entornos que no sean de producción o cuando compartas datos con fines de prueba o resolución de problemas.

- Copia de seguridad de los datos y recuperación en caso de catástrofe: Realiza periódicamente copias de seguridad y réplicas de los datos críticos para garantizar la disponibilidad de los datos y la recuperabilidad en caso de pérdida de datos o fallos del sistema. Aprovecha los servicios de copia de seguridad y recuperación ante desastres de Azure para proteger tus datos.

- Detección y supervisión de amenazas: Utiliza Azure Defender para detectar y responder a las amenazas de seguridad y configura mecanismos de supervisión y alerta para identificar actividades sospechosas o infracciones. Aprovecha Azure Sentinel para la detección y respuesta ante amenazas avanzadas.

- Retención y eliminación de datos: Establece políticas de retención y eliminación de datos para adherirse a las normativas de cumplimiento. Implementa métodos de eliminación seguros para los datos que ya no sean necesarios y mantén un registro de auditoría de las actividades de retención y eliminación de datos.

- Cumplimiento y privacidad de los datos: Garantiza el cumplimiento de las normas de protección de datos pertinentes, como GDPR o HIPAA, mediante la implementación de controles de privacidad y la obtención de los consentimientos o permisos necesarios para las actividades de procesamiento de datos.

- Evaluaciones periódicas de la seguridad: Realiza evaluaciones periódicas de seguridad, escaneos de vulnerabilidad y pruebas de penetración para identificar y abordar cualquier debilidad o vulnerabilidad de seguridad en las medidas de seguridad de datos de su aplicación LLM.

- Concienciación y formación de los empleados: Educa a tus empleados sobre las mejores prácticas de seguridad de datos, la importancia de manejar los datos de forma segura y los riesgos potenciales asociados con las violaciones de datos. Anímales a seguir diligentemente los protocolos de seguridad de datos.

Segregación de datos para distintos entornos

Es muy importante tener en cuenta la segregación de datos o separación de entornos de datos, que es una práctica de seguridad que consiste en mantener distintos tipos de datos separados entre sí para reducir los riesgos. Esto es especialmente importante cuando se trata de datos sensibles en entornos de producción y no producción.

En el caso de Azure OpenAI y servicios como Azure AI Search (anteriormente conocido como Azure Cognitive Search), es crucial adoptar una estrategia que aísle los datos sensibles para evitar la exposición accidental. He aquí cómo podrías hacerlo:

- Separación por entorno: Mantén los datos de producción separados de los de desarrollo y pruebas. Utiliza únicamente datos sensibles reales en producción y datos anónimos o sintéticos en los entornos de desarrollo y pruebas.

- Configuración del servicio de búsqueda: En Azure AI Search, puedes adaptar tus consultas de búsqueda con filtros de texto para proteger la información sensible. Asegúrate de que las configuraciones de búsqueda están establecidas para evitar la exposición innecesaria de datos confidenciales.

- Segregación de índices: Si tienes distintos niveles de sensibilidad de los datos, considera la posibilidad de crear índices separados para cada nivel. Por ejemplo, podrías tener un índice para datos generales y otro para datos confidenciales, cada uno gobernado por protocolos de acceso diferentes.

- Datos sensibles en instancias separadas: Lleva la segregación un paso más allá colocando los conjuntos de datos sensibles en instancias diferentes del servicio. Cada instancia puede controlarse con su propio conjunto específico de políticas RBAC.

Tratamiento de datos en grandes modelos lingüísticos (LLM)

Los datos utilizados en los modelos, como las incrustaciones y los vectores, deben tratarse con el mismo rigor que otros tipos de datos. Aunque estos datos no sean inmediatamente legibles, siguen representando información que podría ser sensible. He aquí cómo tratarla:

- Manejo de Datos Sensibles: Reconoce que las incrustaciones y los vectores generados a partir de información sensible son en sí mismos sensibles. Estos datos deben recibir las mismas medidas de protección que el material de origen.

- Aplicación estricta de RBAC (Role-Based Access Controls): Aplica estrictamente controles de acceso basados en funciones a cualquier servicio que almacene o procese incrustaciones y vectores. El acceso sólo debe concederse en función de la necesidad para la función en cuestión.

- Políticas de acceso con alcance: Utilizando RBAC, asegúrate de que las políticas se ajustan adecuadamente a la necesidad del rol, lo que podría significar acceso de sólo lectura a ciertos datos, o ningún acceso a conjuntos de datos particularmente sensibles.

Al tratar los datos utilizados y generados por las aplicaciones GenAI con la misma preocupación por la privacidad y la seguridad que el almacenamiento de datos tradicional, estarás mejor protegido frente a posibles infracciones. Un enfoque segregado reduce el perfil de riesgo al limitar la exposición sólo a aquellos que necesitan acceso para su función específica, minimizando el posible «radio de explosión» en caso de fuga de datos. Revisar y auditar periódicamente estas prácticas también es esencial para mantener un entorno de datos seguro.

Seguridad de la red

La seguridad de la red se refiere a la protección de la infraestructura de red y los canales de comunicación utilizados por los LLM y sus servicios. La seguridad de red implica garantizar el aislamiento, la segmentación y el cifrado del tráfico de red, así como prevenir y detectar ataques de red. Algunas de las mejores prácticas de seguridad de red para aplicaciones GenAI en Azure son:

- Utilizar protocolos de comunicación seguros: Utilizar protocolos de comunicación seguros como HTTPS/TLS para asegurar que los datos transmitidos entre la aplicación LLM y los clientes o servicios externos estén encriptados y protegidos de interceptación.

- Implementa cortafuegos y sistemas de detección de intrusiones (IDS): configura cortafuegos e IDS para supervisar el tráfico de red e identificar cualquier intento de acceso no autorizado o actividad sospechosa dirigida a la aplicación LLM.

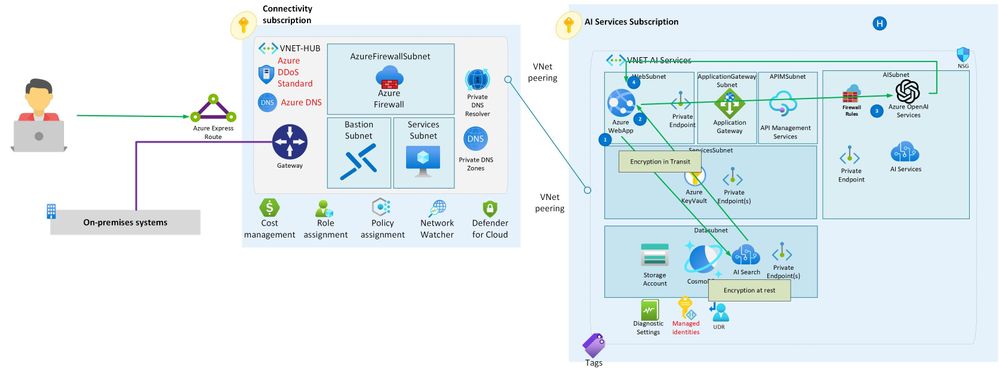

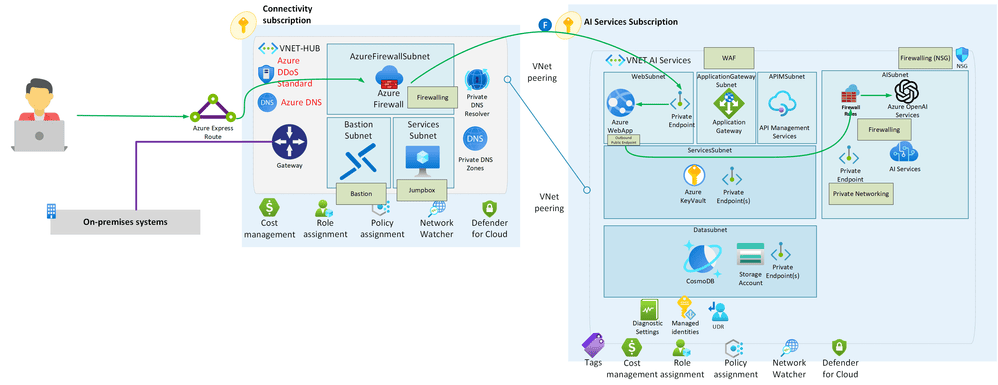

- Para proteger los servicios de IA en Azure, es fundamental implementar una estrategia de seguridad de red completa que utilice puntos finales privados, reglas de cortafuegos, grupos de seguridad de red (NSG) y una topología de red de concentrador y radios bien diseñada. Empieza por configurar puntos finales privados para los servicios de IA; esto garantiza que los servicios sólo sean accesibles dentro de tu red virtual. Complemente esto con reglas de cortafuegos estrictas para controlar el tráfico entrante y saliente. Utilice NSG para definir con mayor precisión el control del tráfico a nivel de subred o para recursos específicos. A nivel de zona de aterrizaje, adopta una topología de concentrador y radios en la que el concentrador sirva como punto central de conectividad y aloje un dispositivo virtual de red (NVA) como Azure Firewall. El tráfico enrutado a través de rutas definidas por el usuario (UDR) en el concentrador permite la inspección centralizada y la gobernanza. Este enfoque por capas proporciona una sólida postura de seguridad para proteger las cargas de trabajo de IA en Azure.

- Controla el acceso a la red: Implemente controles de acceso y segmentación de red para restringir el acceso a la aplicación LLM únicamente a los usuarios y sistemas autorizados. Esto ayuda a evitar accesos no autorizados y posibles movimientos laterales dentro de la red.

- Proteje las API y los puntos finales: Asegúrate de que las API y los puntos finales utilizados por la aplicación LLM estén debidamente protegidos con mecanismos de autenticación y autorización, como claves de API u OAuth, para evitar el acceso no autorizado.

- Implementa una autenticación fuerte: Aplica mecanismos de autenticación fuerte, como la autenticación multifactor, para evitar el acceso no autorizado a la aplicación LLM y a los recursos de red asociados.

- Actualiza y parchea periódicamente la infraestructura de red: Mantén actualizados los dispositivos de red, enrutadores, conmutadores y cortafuegos con el firmware y los parches de seguridad más recientes para solucionar cualquier vulnerabilidad.

- Utiliza la supervisión y el registro de la red: Implementa herramientas de supervisión de red para detectar y analizar el tráfico de red en busca de actividades sospechosas o maliciosas. Habilita el registro para capturar eventos de red y facilitar el análisis forense en caso de incidentes de seguridad.

- Realiza periódicamente auditorías de seguridad y pruebas de penetración: Realiza auditorias de seguridad y pruebas de penetracion para identificar y solucionar cualquier debilidad o vulnerabilidad en la infraestructura de red de la aplicacion LLM.

- Implementa políticas de contraseñas seguras: Aplica políticas de contraseñas seguras para los dispositivos de red, servidores y cuentas de usuario asociados con la aplicación LLM para evitar el acceso no autorizado debido a contraseñas débiles.

- Educa a los usuarios y empleados: Ofrece programas de formación y concienciación para educar a los usuarios y empleados sobre las mejores prácticas de seguridad de la red, como la importancia de utilizar contraseñas seguras, evitar enlaces o descargas sospechosas y notificar cualquier incidente o problema de seguridad.

Seguridad de acceso e identidad

La seguridad de acceso se refiere a la protección de la gestión de acceso e identidad de los LLM y sus servicios. La seguridad de acceso implica asegurar la autenticación, autorización y auditoría de los usuarios y aplicaciones que interactúan con los LLMs y sus servicios, así como gestionar los roles y permisos de los LLMs y sus servicios. Algunas de las mejores prácticas de seguridad de acceso para aplicaciones GenAI en Azure son:

- Utilizar Identidades Gestionadas: Aprovecha Azure Managed Identities para autenticar y autorizar tu aplicación LLM sin necesidad de gestionar claves o credenciales manualmente. Proporciona una solución de identidad segura y cómoda.

- Implemente el control de acceso basado en roles (RBAC · Role-Based Access Controls): Utiliza RBAC para conceder los permisos adecuados a los usuarios, grupos o servicios que accedan a tu aplicación LLM. Sigue el principio del menor privilegio, concediendo sólo los permisos necesarios para cada entidad.

- Gestión segura de claves: Almacena y gestiona claves de forma segura utilizando Azure Key Vault. Evita codificar o incrustar claves sensibles en el código de tu aplicación LLM. En su lugar, recupéralas de forma segura desde Azure Key Vault utilizando identidades gestionadas.

- Implemente la rotación y caducidad de claves: Rota y expira regularmente las claves almacenadas en Azure Key Vault para minimizar el riesgo de acceso no autorizado. Sigue las prácticas de rotación de claves recomendadas específicas para su caso de uso y los requisitos de cumplimiento.

- Cifra los datos en reposo y en tránsito: Utiliza los servicios y mecanismos de cifrado de Azure para proteger los datos en reposo y en tránsito. Cifra los datos confidenciales almacenados en su aplicación LLM y utilice protocolos de comunicación seguros como HTTPS/TLS para la transmisión de datos.

- Supervisa y detecta actividades anómalas: Configura mecanismos de supervisión y registro para detectar actividades anómalas o posibles amenazas a la seguridad relacionadas con su aplicación LLM. Utiliza Azure Security Center o Azure Sentinel para supervisar comportamientos sospechosos.

- Habilita la autenticación multifactor (MFA): Implementa MFA para añadir una capa adicional de seguridad para la autenticación de usuarios. Aplica MFA para cuentas privilegiadas u operaciones sensibles relacionadas con su aplicación LLM.

- Revisa y actualiza periódicamente los controles de acceso: Realiza revisiones periódicas de los controles de acceso para asegurarte de que los permisos y roles asignados a usuarios y servicios están actualizados. Elimina rápidamente los derechos de acceso innecesarios para minimizar los riesgos de seguridad: Sigue prácticas de codificación seguras para evitar vulnerabilidades comunes como ataques de inyección, secuencias de comandos en sitios cruzados (XSS) o errores de configuración de seguridad. Utilice la validación de entradas y las consultas parametrizadas para mitigar los riesgos de seguridad.

Seguridad de las aplicaciones

La seguridad de las aplicaciones se refiere a la protección de la lógica de aplicación y la funcionalidad de los LLM y sus servicios. La seguridad de las aplicaciones implica asegurar la calidad, precisión y fiabilidad de los resultados y comportamientos de los LLMs, así como prevenir y mitigar el mal uso o abuso de los LLMs por parte de actores maliciosos o usuarios no intencionados. Algunas de las mejores prácticas de seguridad de aplicaciones para aplicaciones GenAI en Azure son:

- Implementar Input Validation: Validar y sanitizar las entradas del usuario para prevenir ataques de inyección y asegurar la integridad de los datos que están siendo procesados por el LLM.

- Aplicar controles de acceso: Implementa mecanismos de autenticación y autorización fuertes para controlar el acceso a las funciones habilitadas por el LLM y garantizar que solo los usuarios autorizados puedan interactuar con la aplicación.

- Proteger los datos de entrenamiento del modelo: Proteje los datos de entrenamiento utilizados para entrenar el LLM frente a accesos no autorizados y garantiza el cumplimiento de la normativa de protección de datos. Utiliza técnicas como la anonimización de datos o la privacidad diferencial para mejorar aún más la seguridad de los datos.

- Supervisar y auditar la actividad del LLM: Implementa mecanismos de registro y supervisión para rastrear la actividad del LLM, detectar comportamientos sospechosos y facilitar el análisis forense en caso de incidentes de seguridad.

- Actualiza y parchea regularmente los componentes del LLM: Mantén actualizados el framework, las bibliotecas y las dependencias del LLM con los últimos parches y actualizaciones de seguridad para mitigar posibles vulnerabilidades.

- Asegura los puntos de integración: Valida y proteje cuidadosamente cualquier fuente de datos externa o API utilizada por el LLM para evitar el acceso no autorizado o la inyección de código malicioso.

- Aplica el principio de mínimo privilegio: Aplica el principio de mínimo privilegio para limitar las capacidades y los derechos de acceso del LLM y los componentes asociados. Concede únicamente los permisos necesarios para evitar posibles usos indebidos.

- Cifra los datos confidenciales: Utiliza mecanismos de cifrado para proteger los datos confidenciales, tanto en reposo como en tránsito, a fin de garantizar su confidencialidad e integridad.

- Realiza pruebas de seguridad periódicas: Realiza evaluaciones de seguridad periódicas, incluyendo pruebas de penetración y escaneo de vulnerabilidades, para identificar y abordar cualquier debilidad o vulnerabilidad de seguridad en la aplicación.

Recuerda que la seguridad es un proceso continuo, y es crucial evaluar y mejorar continuamente la postura de seguridad de las aplicaciones GenAI para protegerse contra las amenazas en evolución.

Seguridad de gobierno

La seguridad de gobernanza se refiere a la protección de la gobernanza y supervisión de los LLM y sus servicios. La seguridad de la gobernanza implica garantizar las implicaciones éticas y sociales de los resultados e impactos de los LLM, así como el cumplimiento de los requisitos legales y normativos.

Algunas de las mejores prácticas de seguridad de gobernanza para aplicaciones GenAI en Azure son:

- Utiliza los términos de servicio, políticas y directrices de Azure OpenAI u otros LLMs para comprender y adherirse a las normas y responsabilidades del uso de los LLMs y sus servicios.

- Utiliza la documentación, los tutoriales y los ejemplos de Azure OpenAI u otros LLM para aprender y seguir las mejores prácticas y recomendaciones de uso de los LLM y sus servicios.

- Utiliza los canales de retroalimentación y soporte de Azure OpenAI u otros LLM para informar y resolver cualquier problema o duda relacionados con los LLM y sus servicios.

- Utiliza Azure Responsible AI u otros marcos y herramientas para evaluar y mitigar los riesgos y daños potenciales de los resultados e impactos de los LLM, como la imparcialidad, la transparencia, la responsabilidad o la privacidad.

- Utilizar Azure Compliance u otros recursos para comprender y cumplir los requisitos legales y normativos y las normas relacionadas con los LLM y sus servicios, como GDPR, HIPAA o ISO

- Utiliza Azure Policy o Azure Security Center para definir y aplicar políticas de seguridad de gobernanza y normas de cumplimiento

- Utiliza Azure Monitor o Azure Sentinel para supervisar y alertar sobre eventos e incidentes de seguridad de gobernanza

Conclusión

Las aplicaciones GenAI son herramientas potentes y versátiles que pueden habilitar varios escenarios y casos de uso en el procesamiento y generación de lenguaje natural. Sin embargo, las aplicaciones GenAI también plantean importantes desafíos de seguridad que deben ser abordados por los desarrolladores y administradores de aplicaciones GenAI. Aqui se proporciona una visión general de las mejores prácticas de seguridad para aplicaciones GenAI en Azure, centrándose en Azure OpenAI pero describiendo también la seguridad relacionada con otros LLM que pueden utilizarse dentro de Azure. Siguiendo estas mejores prácticas, los desarrolladores y administradores pueden garantizar la seguridad de sus aplicaciones GenAI y sus dominios de datos, red, acceso, aplicación y gobernanza.

Este post está basado la publicación del blog de Azure dentro de la Comunidad técnica de Microsoft: «Security Best Practices for GenAI Applications (OpenAI) in Azure» por Freddy Ayala (Cloud Solution Architect en Microsoft).