Ejecuta DeepSeek R1 en un ordenador de 6.000 €

Configuración completa de hardware + software para ejecutar Deepseek-R1 localmente. El modelo real, sin restricciones.

Un coste total de cerca de 6.000 euros para ejecutar el modelo real, sin destilaciones, y cuantización Q8 para una calidad total.

Componentes del ordenador para ejecutar R1

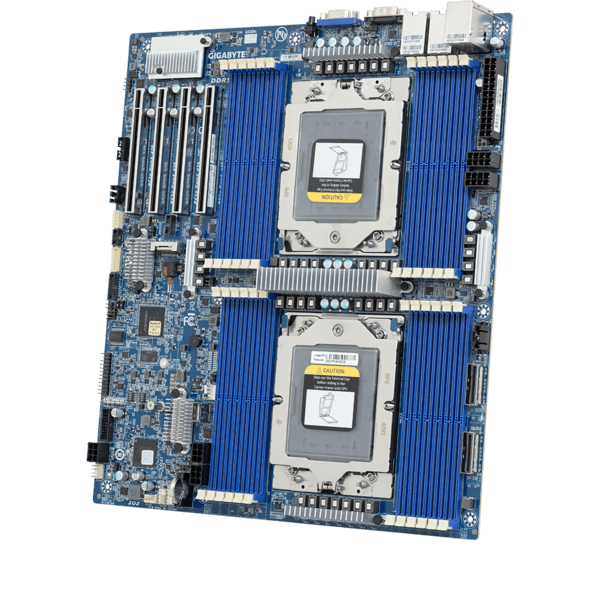

Placa base: Gigabyte MZ73-LM0 o MZ73-LM1. Queremos 2 zócalos EPYC para conseguir 24 canales de RAM DDR5 para maximizar el tamaño y el ancho de banda de la memoria.

CPU: 2 unidades de cualquier CPU AMD EPYC 9004 o 9005. La generación LLM se ve limitada por el ancho de banda de la memoria, así que no necesitas un procesador de gama alta. Con una CPU 9115 o incluso la 9015 se pueden reducir costes.

RAM: Esta es la más importante. Vamos a necesitar 768 GB (para que quepa el modelo) en 24 canales de RAM (para conseguir el ancho de banda necesario para que funcione lo suficientemente rápido). Eso significa 24 módulos DDR5-RDIMM de 32 GB.

CAJA: Puedes montarlo en una torre estándar, pero asegúrate de que tiene tornillos para una placa base de servidor completa, algo que la mayoría de las carcasas de consumo no tienen.

FUENTE DE ALIMENTACIÓN: El consumo de energía de este sistema es sorprendentemente bajo (<400 W); pero necesitarás muchos cables de alimentación de CPU para 2 CPU EPYC. El Corsair HX1000i tiene suficientes.

DISIPADOR: Esta es la parte complicada. AMD EPYC es socket SP5, y la mayoría de los disipadores de calor para SP5 asumen que montas en un rack 2U/4U (que no es el caso). Hay que recurrir a Ebay/Aliexpress para conseguir unos que valgan.

Y si los ventiladores del disipador son muy ruidosos se pueden sustituir por unos eficientes y silenciosos como: Noctua NF-A12x25 PWM / Arctic Freezer 4U-SP5.

Y por último, el SSD: Cualquier SSD de 1TB o más que pueda caber en el R1 nos valen; mejor si es NVMe porque hay que copiar 700GB a la RAM cuando se inicie el modelo.

¡Y ese es el sistema! Móntalo y ponle Linux.

Además, un consejo importante: entra en la BIOS y ajusta el número de grupos NUMA a 0. Esto asegurará que cada capa del modelo se intercalará en todos los chips de RAM, duplicando nuestro rendimiento. No lo olvides.

Software para ejecutar R1

Sigue estas instrucciones para instalar llama.cpp

A continuación, el modelo. ¡Es hora de descargar 700 gigabytes desde HuggingFace! Coge todos los archivos de la carpeta Q8_0.

Lo creas o no, casi has terminado. Hay formas más elegantes de configurarlo, pero para una demostración rápida, simplemente haz esto.

llama-cli -m ./DeepSeek-R1.Q8_0-00001-of-00015.gguf --temp 0.6 -no-cnv -c 16384 -p "<|User|>How many Rs are there in strawberry?<|Assistant|>"Si todo va bien, deberías pasar un breve periodo de carga y que después un LLM local de última generación empiece a reflexionar sobre la pregunta:

Y una vez que pase la prueba, sólo tienes que utilizar llama-server para alojar el modelo y pasar las peticiones de tu otro software. Ahora dispones de inteligencia de nivel fronterizo alojada por completo en tu máquina local, ¡todo de código abierto y de uso gratuito!

Velocidad de generación: 6 a 8 tokens por segundo

La velocidad de generación en esta versión es de 6 a 8 tokens por segundo, dependiendo de la CPU específica y la velocidad de RAM, o un poco menos si tienes un largo historial de chat.

¿Significa esto que cuando le haces una pregunta, responde con 4,5 palabras por segundo? Si.

La regla de oro es que 1 token son aproximadamente 0,75 palabras:

- 6 tokens por segundo son 4,5 palabras por segundo y 8 tokens por segundo son 6 palabras por segundo

¿6 a 8 tokens por segundo es suficiente? Para trabajar de forma cómoda con el modelo en local, necesitamos una velocidad de 10 a 15 tokens por segundo.

- 10 tokens son 7,5 palabras y

- 15 tokens son 11,25 palabras.

OJO: ¡no hay GPU en esta versión! Si quieres alojar en la GPU para una mayor velocidad de generación, ¡puedes hacerlo! Eso si, perderás mucha calidad por la cuantización y si quieres Q8 necesitarás >700GB de memoria GPU, lo que probablemente costará más de 100.000 euroa.

Preguntas acerca del montaje

¿Con una GPU obtendré más velocidad? Las GPUs no ayudarán mucho a la velocidad de generación, porque el modelo es demasiado grande para caber su memoria y el intercambio a través de PCI-E es mucho más lento que la lectura desde RAM.

¿Se obtendrían más tokens por segundo con CPUs más rápidas; por ejemplo con 2x 9375F? Habría algún aumento de velocidad, ¡pero probablemente no mucho! La razón es que la generación de texto a partir de LLMs se ve limitada por el ancho de banda de la memoria para leer los pesos de la RAM una y otra vez. Si el 9375F tiene mejor ancho de banda que un 9115, entonces será más rápido, pero habría que ver si esto es asi.

¿La memoria sería un límite para la longitud del contexto? Con 768GB la longitud del contexto no es un límite. El modelo es de 650 GB, así que hay otros ~100 GB para caché. Probablemente habría que llegar a unos 100.000 a 150.000 tokens antes de agotar la memoria.

Si la idea es prescindir de la GPU y cargarla sólo con RAM, ¿podrías hacer lo mismo y ejecutar el modelo de 70b en una máquina de unos 600 dólares? Sí, se puede. Aunque la velocidad va a ser muy lenta – Deepseek es extremadamente rápido para un modelo de 650B porque sólo se utilizan unos 45B de parámetros para cada token. Tiene el tamaño de un modelo de 650B pero la velocidad de uno de 45B.

¿Qué influencia tiene el ancho de banda sobre los tokens por segundo? El ancho de banda de la memoria lo es todo. Este sistema tiene alrededor de 1TB/seg de ancho de banda y genera 6-8 tokens/segundo. Si tu sistema tiene 250GB/seg de ancho de banda, entonces puedes esperar 1,5 – 2 tokens/segundo.

¿No sería mejor utilizar un Mac Studio con M2 ultra (pronto M4 ultra) y 192 GB de memoria unificada? Eso funcionaria muy bien, excepto que el peso del modelo completo es de 650GB. Esto se podría conseguir con 4 Mac Studio configurados al máximo unidos con Thunderbolt (lo que a día de hoy son unos 28.000 euros) o 7 Mac Mini configurados al máximo (unos 15.000 euros). Aquí habría que esperar a que Apple anuncie los nuevos Studio que según Macrumor hay muchas posibilidades de que el m4 ultra te permita ejecutar 256GB de ram en cada uno, por lo que sólo se necesitarían dos máquinas, y correrían a 57 tokens por segundo.

Información basada en la publicación en X/Twitter de Matthew Carrigan (Ingeniero en Hugging Face).