Tres formas de usar Llama 3.1 en local (gratis y sin internet)

Con el lanzamiento de Llama 3.1 te explico tres formas gratuitas para ejecutar el modelo en local sin tener que estar conectado a Internet.

Yo normalmente uso GPT4All y aquí os explico como ejectuar Llama en tu ordenador. Pero por lo que estoy viendo la gente tiene otras preferencias; siendo la menos usada la que uso yo:

- LM Studio AI

- Ollama

- GPT4All

Al final es que vayas probando todo y viendo que es más cómodo para ti.

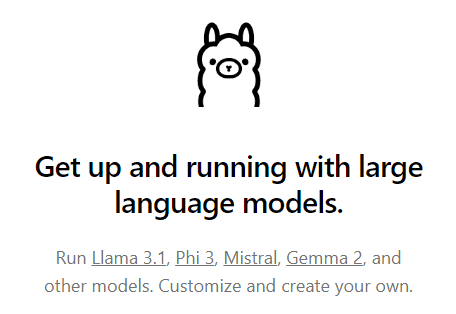

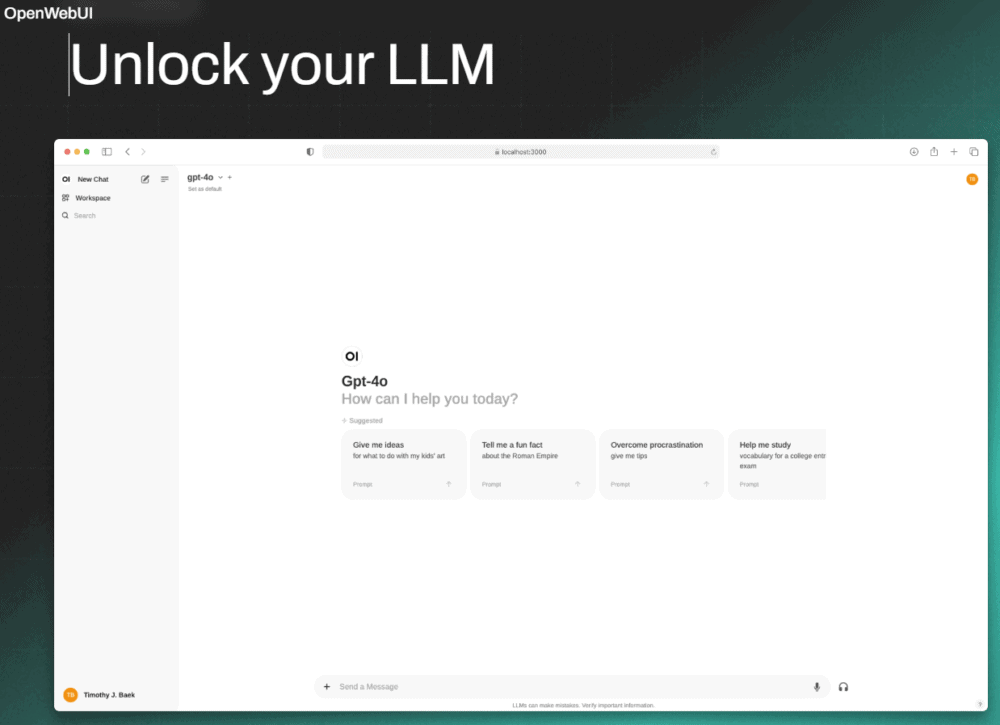

Ollama + OpenWebUI

Ollama es un proyecto de código abierto que proporciona una manera fácil de descargar y ejecutar LLMs locales como Llama 3.1 en tu ordenador.

Ollama se integra con el proyecto OpenWebUI, que te proporciona una interfaz de usuario basada en web tipo ChatGPT para interactuar con los LLMs locales.

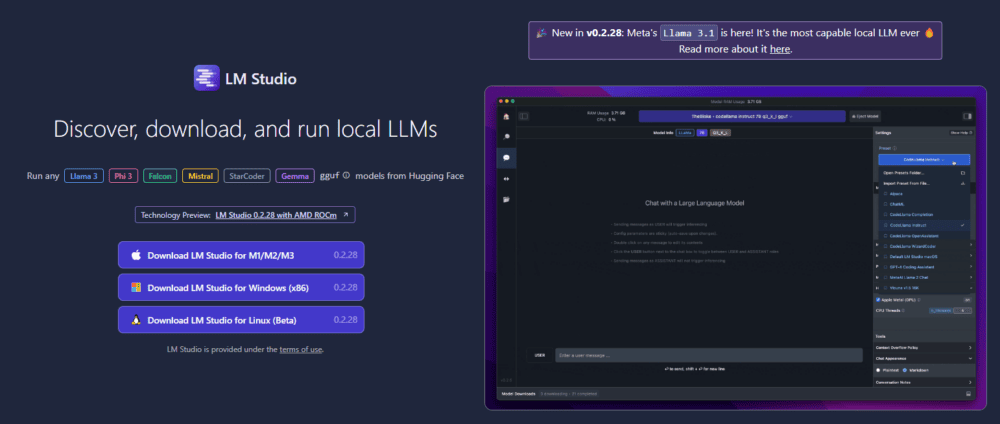

LM Studio

LM Studio es una aplicación de escritorio diseñada para ejecutar LLMs locales y de código abierto como Llama 3.1 en tu ordenador.

Es una herramienta que te permite ejecutar Llama 3.1 y otros LLMs opensource offline en tu PC local.

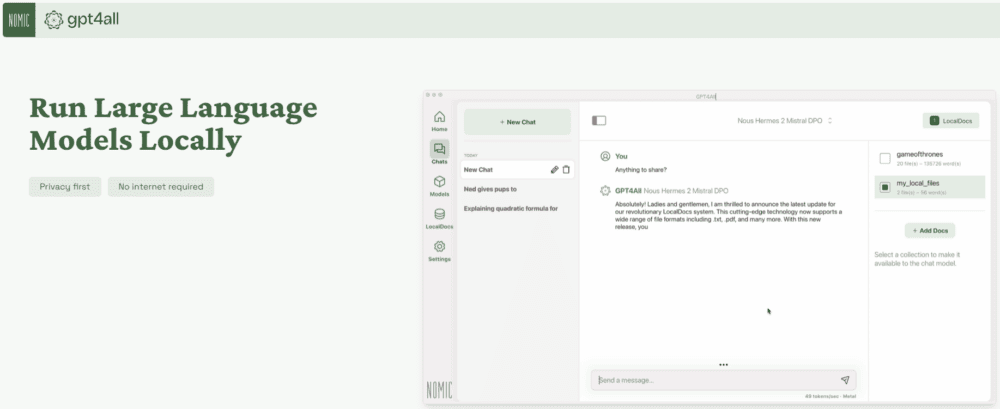

GPT4All

GPT4All es un ecosistema opensource para ejecutar LLMs localmente en tu ordenador. Funciona sin conexión a Internet ni GPU, garantizando privacidad y accesibilidad.

Aquí tenéis el los enlaces para probar las distintas formas de ejecutar Llama 3.1 en local: Ollama & OpenWebUI, LM Studio y Nomic GPT4All.