Meta lanza Llama 3.1, el modelo de IA Open Source más potente

Meta ha lanzado Llama 3.1. El modelo de IA de código abierto que puedes afinar, pulir y desplegar en cualquier lugar.

El resumen de esta situación es que Meta ha invertido en entrenar un modelo a la altura de sus dos competidores principales (GPT-4 y Claude Sonnet 3.5) y lo ha puesto en descarga libre para que todo el mundo lo pueda ejecutar en local.

Hasta ahora, los grandes modelos de lenguaje de código abierto no alcanzaban el nivel de sus contrapartes de código cerrado en términos de características y rendimiento. Llama 3.1 405B es el modelo de lenguaje a gran escala de código abierto más potente hasta la fecha.

Introducción a Llama 3.1

Llama 3.1 405B es el primer modelo disponible de forma abierta que rivaliza con los mejores modelos de IA en lo que se refiere conocimiento general, maniobrabilidad, matemáticas, uso de herramientas y traducción multilingüe. Con el lanzamiento del modelo 405B, Meta está preparado para potenciar la innovación, con oportunidades de crecimiento y exploración sin precedentes. La última generación de Llama dará lugar a nuevas aplicaciones y paradigmas de modelado, incluida la generación de datos sintéticos para permitir la mejora y el entrenamiento de modelos más pequeños, así como la destilación de modelos, una capacidad que nunca se ha logrado a esta escala en código abierto.

Como parte de este último lanzamiento, se han presentado versiones mejoradas de los modelos 8B y 70B. Estos modelos son multilingües y tienen una longitud de contexto significativamente mayor, de 128K, un uso de herramientas de última generación y capacidades de razonamiento más potentes en general. De este modo, los modelos más recientes son compatibles con casos de uso avanzados, como el resumen de textos extensos, los agentes conversacionales multilingües y los asistentes de codificación.

También se han introducido cambios en la licencia, lo que permite a los desarrolladores utilizar los resultados de los modelos Llama, incluido el 405B, para mejorar otros modelos. Y fieles al compromiso con el código abierto, estos modelos están a disposición de la comunidad para su descarga, así como para su desarrollo inmediato en el amplio ecosistema de plataformas asociadas.

El sistema Llama

Los modelos Llama siempre se concibieron para funcionar como parte de un sistema global que puede orquestar varios componentes, incluida la llamada a herramientas externas. La visión de Meta es ir más allá de los modelos básicos para dar a los desarrolladores acceso a un sistema más amplio que les proporcione la flexibilidad necesaria para diseñar y crear ofertas personalizadas que se ajusten a su visión. Este pensamiento comenzó el año pasado cuando se introdujo por primera vez la incorporación de componentes fuera del núcleo de LLM.

Como parte de sus esfuerzos continuos por desarrollar la IA de forma responsable más allá de la capa del modelo y ayudar a otros a hacer lo mismo, están publicando un sistema de referencia completo que incluye varias aplicaciones de muestra y nuevos componentes como Llama Guard 3, un modelo de seguridad multilingüe, y Prompt Guard, un filtro de inyección de avisos. Estas aplicaciones de muestra son de código abierto y pueden ser desarrolladas por la comunidad.

La implementación de los componentes de esta visión del sistema Llama aún está fragmentada. Por eso se ha empezado a trabajar con la industria, las startups y la comunidad en general para ayudar a definir mejor las interfaces de estos componentes. Para apoyar esto, se ha lanzando una solicitud de comentarios en GitHub para lo que han llamando «Llama Stack». Llama Stack es un conjunto de interfaces estandarizadas y basadas en opiniones sobre cómo construir componentes canónicos de la cadena de herramientas (ajuste fino, generación de datos sintéticos) y aplicaciones agénticas. Meta espera que se adopten en todo el ecosistema, lo que facilitará la interoperabilidad.

La transparencia impulsa la innovación

A diferencia de los modelos cerrados, los modelos Llama pueden descargarse. Los desarrolladores pueden personalizar completamente los modelos según sus necesidades y aplicaciones, entrenarlos con nuevos conjuntos de datos y realizar ajustes adicionales. De este modo, la comunidad de desarrolladores en general y el resto del mundo pueden aprovechar mejor la potencia de la IA generativa. Los desarrolladores pueden personalizar completamente sus aplicaciones y ejecutarlas en cualquier entorno, ya sea on prem, en la nube o incluso localmente en un portátil, todo ello sin compartir datos con Meta.

Aunque muchos pueden argumentar que los modelos cerrados son más rentables, los modelos Llama ofrecen uno de los costes por token más bajos del sector, según las pruebas realizadas por Artificial Analysis. Y como señaló Mark Zuckerberg, el código abierto garantizará que más personas de todo el mundo tengan acceso a los beneficios y oportunidades de la IA, que el poder no se concentre en manos de unos pocos y que la tecnología pueda desplegarse de forma más uniforme y segura en toda la sociedad. Por eso meta sigue dando pasos para que la IA de acceso abierto se convierta en la norma del sector.

Se ha visto a la comunidad crear cosas increíbles con modelos Llama anteriores, incluyendo un compañero de estudio de IA construido con Llama y desplegado en WhatsApp y Messenger, un LLM adaptado al campo de la medicina diseñado para ayudar a guiar la toma de decisiones clínicas, y una startup sin ánimo de lucro del sector sanitario en Brasil que facilita al sistema sanitario organizar y comunicar la información de los pacientes sobre su hospitalización, todo ello de una forma segura para los datos. Todos estamos impacientes por ver lo que se construye con los últimos modelos gracias al poder del código abierto.

Desarrollar y construir con Llama 3.1 405B

Para el desarrollador medio, utilizar un modelo a la escala del 405B es todo un reto. Aunque se trata de un modelo increíblemente potente, requiere importantes recursos informáticos y experiencia para trabajar con él. Meta quiere que todo el mundo pueda sacar el máximo partido del 405B:

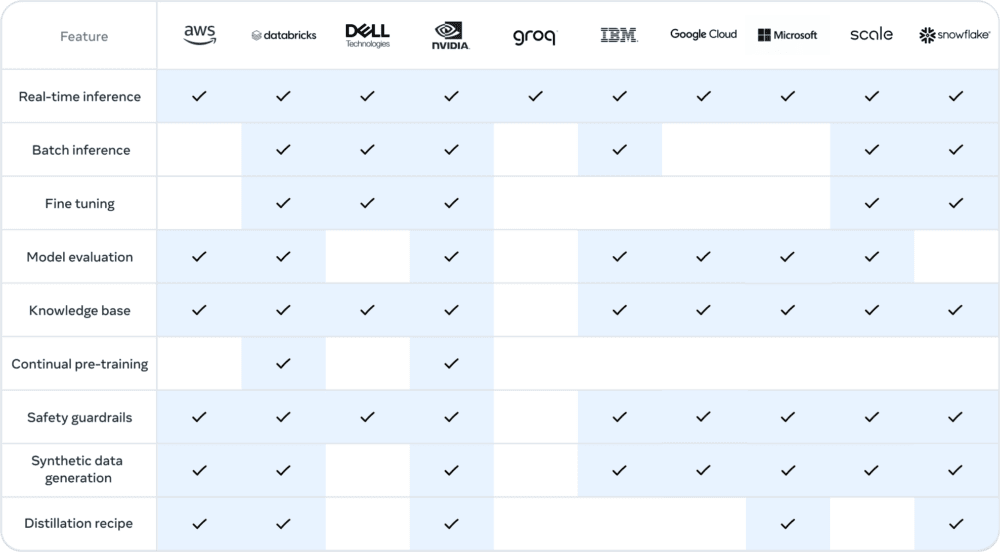

- Inferencia en tiempo real y por lotes

- Ajuste fino supervisado

- Evaluación de su modelo para su aplicación específica

- Preentrenamiento continuo

- Generación mejorada por recuperación (RAG)

- Llamada a funciones

- Generación de datos sintéticos

Aquí es donde el ecosistema Llama puede ayudar. Desde el primer día, los desarrolladores pueden aprovechar todas las capacidades avanzadas del modelo 405B y empezar a construir inmediatamente. Los desarrolladores también pueden explorar flujos de trabajo avanzados como la generación de datos sintéticos fáciles de usar, seguir instrucciones llave en mano para la destilación de modelos y habilitar RAG sin problemas con soluciones de socios, incluidos AWS, NVIDIA y Databricks. Además, Groq ha optimizado la inferencia de baja latencia para los despliegues en la nube, y Dell ha logrado optimizaciones similares para los sistemas on-prem.

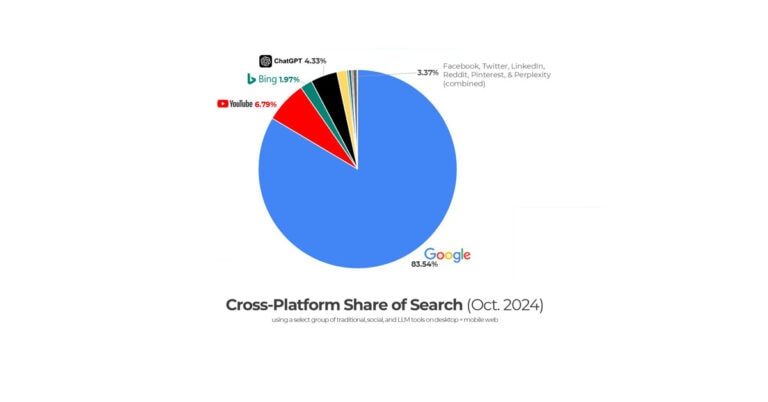

El ecosistema está configurado y listo para funcionar con más de 25 socios, entre ellos AWS, NVIDIA, Databricks, Groq, Dell, Azure y Google Cloud, que ofrecen servicios desde el primer día.

Prueba hoy mismo la colección de modelos Llama 3.1

Hay mucho potencial para crear nuevas experiencias útiles utilizando el multilingüismo y la mayor longitud del contexto. Antes de lanzar un modelo, Meta trabaja para identificar, evaluar y mitigar los riesgos potenciales a través de varias medidas, entre las que se incluyen ejercicios de descubrimiento de riesgos previos al despliegue mediante red teaming y ajustes de seguridad. Por ejemplo, se llevan a cabo extensos ejercicios de red teaming con expertos externos e internos para someter los modelos a pruebas de estrés y encontrar formas inesperadas de utilizarlos.

Aunque este es el modelo más grande de Meta hasta la fecha, todavía hay mucho terreno por explorar en el futuro, incluidos tamaños más adaptados a los dispositivos, modalidades adicionales y una mayor inversión en la capa de la plataforma de agentes.

Ejecuta Llama-3.1 en tu ordenador

Las instrucciones de Ejecuta Llama-3 en tu ordenador también son válidas para Llama 3.1.

Información basada en la presentación de Llama 3.1 en el blog de IA de META: «Introducing Llama 3.1: Our most capable models to date«. Empieza usando Llama 3.1 aquí. Encuentra el paper de Llama 3.1 aquí. Visita Llama en Github aquí. Descarga Llama 3.1 en Hugging Face aquí.