Microsoft garantiza la seguridad de su IA generativa 🛡️

Microsoft se compromete a garantizar que sus sistemas de IA se utilicen de forma segura, responsable y ética.

En el último año, la IA generativa ha experimentado un enorme crecimiento en popularidad y está siendo adoptada cada vez más por personas y organizaciones. En el mejor de los casos, la IA puede proporcionar una inspiración increíble y ayudar a desbloquear nuevos niveles de creatividad y productividad. Sin embargo, como ocurre con todas las nuevas tecnologías, un pequeño subgrupo de personas puede intentar hacer un mal uso de estas potentes herramientas. En Microsoft, están centrados en minimizar los riesgos de un uso dañino de estas tecnologías y se comprometen a mantener estas herramientas aún más fiables y seguras.

Aquí se van a describir las medidas que estamos tomando para garantizar una experiencia segura a los clientes que utilizan nuestros servicios de consumo, como el sitio web Copilot y Microsoft Designer.

Proceso de IA responsable y mitigación

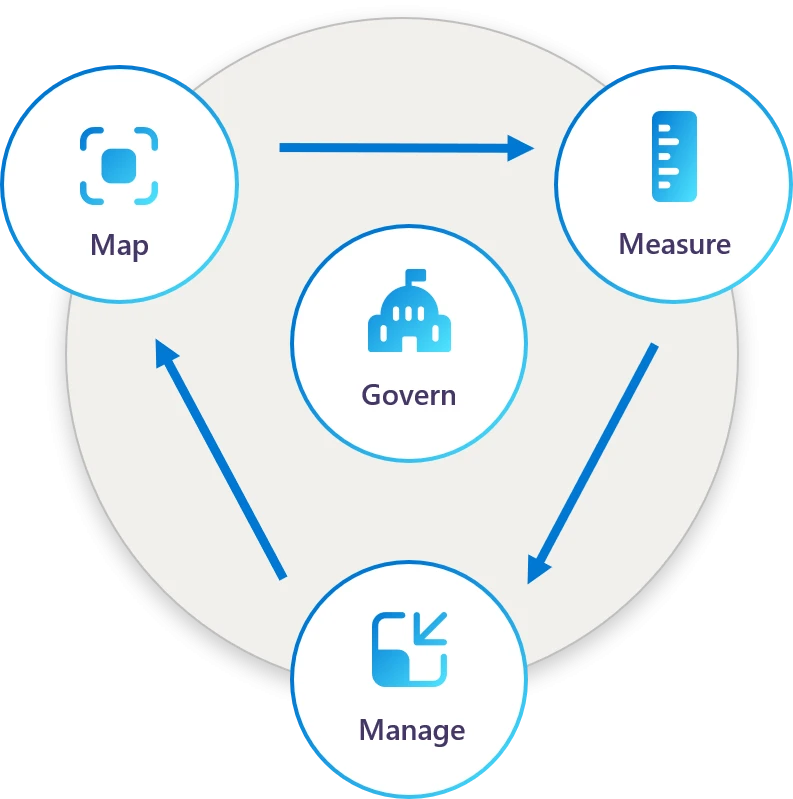

Desde 2017, Micrsooft ha estado construyendo un programa de IA responsable que ayuda a mapear, medir y gestionar los problemas antes y después del despliegue. La gobernanza es fundamental en todas las etapas del framework de Mapeo, Medición y Gestión, como se ilustra a continuación. Este enfoque general refleja las funciones básicas del marco de gestión de riesgos de la IA del NIST.

El framework: Mapear, Medir y Gestionar

Mapear

Mapear: La mejor manera de desarrollar sistemas de IA de forma responsable es identificar los problemas y relacionarlos con los escenarios de los usuarios y con nuestros sistemas técnicos antes de que se produzcan. Con cualquier tecnología nueva, esto supone un reto porque es difícil prever todos los usos potenciales. Por ese motivo, Microsoft dispone de varios tipos de controles para ayudar a identificar posibles riesgos y escenarios de uso indebido antes de su despliegue. Utilizan técnicas como las evaluaciones responsables del impacto de la IA para identificar los posibles resultados positivos y negativos de nuestros sistemas de IA en una serie de escenarios y en la medida en que podrían afectar a diversas partes interesadas. Las evaluaciones de impacto son obligatorias para todos los productos de IA, y ayudan a fundamentar nuestras decisiones de diseño y despliegue.

También se lleva a cabo un proceso denominado «red teaming» que simula ataques y escenarios de uso indebido, junto con escenarios de uso general que podrían dar lugar a resultados perjudiciales, en nuestros sistemas de IA para probar su solidez y resistencia frente a entradas y salidas maliciosas o no intencionadas. Estos resultados se utilizan para mejorar nuestras medidas de seguridad y protección.

Medir

Medir: Aunque los procesos de mapeo, como las evaluaciones de impacto y la formación de «red teaming«, ayudan a identificar los riesgos, Microsoft recurre a enfoques de medición más sistemáticos para desarrollar métricas que les ayuden a comprobar, a escala, esos riesgos en sus sistemas de IA antes y después de su despliegue. Esto incluye la supervisión continua a través de un conjunto de datos diverso y polifacético que representa varios escenarios en los que pueden surgir amenazas. También establecemos directrices para anotar conjuntos de datos de medición que nos ayuden a desarrollar métricas, así como a construir clasificadores que detecten contenidos potencialmente dañinos, como contenidos para adultos, contenidos violentos y discursos de odio.

Microsoft está trabajando para automatizar sus sistemas de medición para ayudar con la escala y la cobertura, y escanean y analizan las operaciones de IA para detectar anomalías o desviaciones del comportamiento esperado. Cuando procede, también establecen mecanismos para aprender de las señales de feedback de los usuarios y de las amenazas detectadas con el fin de reforzar nuestras herramientas de mitigación y estrategias de respuesta a lo largo del tiempo.

Gestionar

Gestionar: Incluso con los mejores sistemas, pueden surgir problemas, por lo que se han creado procesos y medidas de mitigación para gestionarlos y evitar que se repitan. Microsoft dispone de mecanismos en cada uno de sus productos para que los usuarios informen de problemas o inquietudes, de modo que cualquiera pueda señalar fácilmente elementos que podrían ser problemáticos, y supervisan cómo interactúan los usuarios con el sistema de IA para identificar patrones que puedan indicar un uso indebido o amenazas potenciales.

Además, Microsoft se esfuerzan por ser transparentes no sólo sobre los riesgos y las limitaciones para fomentar la intervención de los usuarios, sino también sobre el hecho de que el propio contenido puede estar generado por IA. Por ejemplo, se toman medidas para revelar al usuario el papel de la IA generativa, y se etiquetan los contenidos sonoros y visuales generados por herramientas de IA. En el caso de contenidos como las imágenes generadas por IA, se usan métodos criptográficos para marcar y firmar los contenidos generados por IA con metadatos sobre su origen e historial, y se han asociado con otros líderes del sector para crear el organismo de normalización Coalition for Content Provenance and Authenticity (C2PA) con el fin de ayudar a desarrollar y aplicar normas de procedencia de contenidos en todo el sector.

Por último, a medida que evoluciona la tecnología de IA generativa, Microsoft actualiza activamente las medidas de mitigación de nuestros sistemas para asegurarnos de que abordamos los riesgos de forma eficaz. Por ejemplo, cuando se actualiza el meta prompt de un producto de IA generativa, lo someten a rigurosas pruebas para garantizar que avanza en sus esfuerzos por ofrecer respuestas seguras y eficaces. Existen varios tipos de filtros de contenidos diseñados para detectar e impedir automáticamente la difusión de contenidos inapropiados o nocivos. Emplean una serie de herramientas para abordar los problemas específicos que pueden plantear las tecnologías de IA de texto, imágenes, vídeo y audio, y recurrimos a protocolos de respuesta a incidentes que activan acciones de protección cuando se identifica una posible amenaza.

Mejora contínua

En Microsoft son conscientes de que algunos usuarios pueden intentar burlar sus medidas de seguridad de IA y utilizar sus sistemas con fines malintencionados. Se toman muy en serio esta amenaza y vigilan y mejoran constantemente sus herramientas para detectar y evitar usos indebidos.

Microsoft se compromete a garantizar que sus sistemas de IA se utilicen de forma segura, responsable y ética.

Información basada la publicación del blog de Microsoft 365 de Microsoft: «Making our generative AI products safer for consumers«.