OpenAI o1: un modelo «más listo» y que razona

OpenAI han desarrollado una nueva serie de modelos de IA diseñados para pasar más tiempo pensando antes de responder.

Pueden razonar sobre tareas complejas y resolver problemas más difíciles que los modelos anteriores en ciencias, codificación y matemáticas.

Esto es un avance y se esperan actualizaciones y mejoras periódicas.

Cómo funciona OpenAI o1

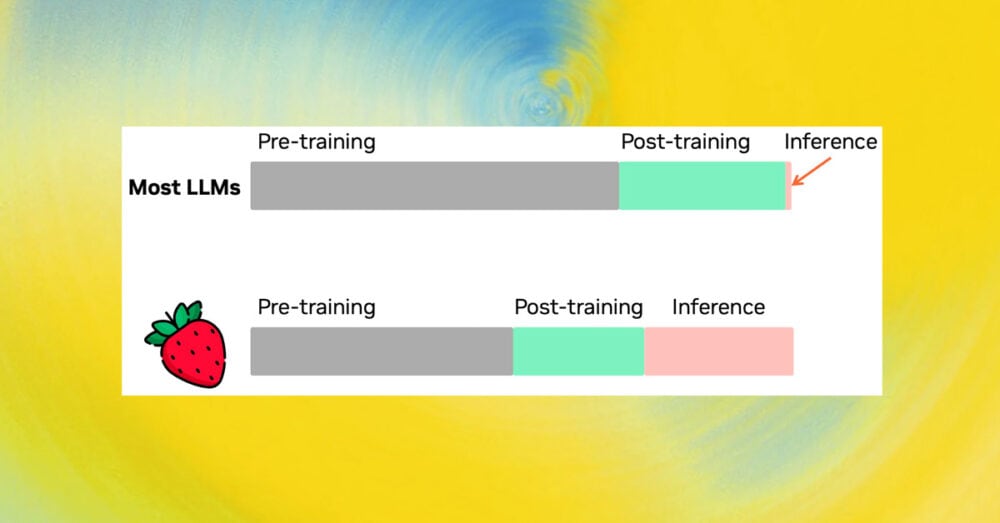

Se han entrenado estos modelos para que dediquen más tiempo a pensar en los problemas antes de responder, como haría una persona. Con el entrenamiento, aprenden a perfeccionar su proceso de pensamiento, probar distintas estrategias y reconocer sus errores.

En las pruebas de OpenAI el modelo obtuvo resultados similares a los de los estudiantes de doctorado en tareas de física, química y biología. También han comprobado que sobresale en matemáticas y codificación. En un examen clasificatorio para la Olimpiada Internacional de Matemáticas (IMO), GPT-4o sólo resolvió correctamente el 13% de los problemas, mientras que el modelo de razonamiento obtuvo un 83%. Sus habilidades de codificación se evaluaron en concursos y alcanzaron el percentil 89 en las competiciones de Codeforces.

Al tratarse de un modelo inicial, aún no dispone de muchas de las funciones que hacen útil a ChatGPT, como la navegación por Internet en busca de información y la carga de archivos e imágenes. Para muchos casos comunes GPT-4o será más capaz a corto plazo.

Pero para tareas de razonamiento complejas esto supone un avance significativo y representa un nuevo nivel de capacidad de IA. Por ello, volvemos a poner el contador en 1 y llamamos a esta serie OpenAI o1.

Ocultar las cadenas de pensamiento

OpenAI cree que una cadena de pensamiento oculta presenta una oportunidad única para supervisar los modelos. Suponiendo que sea fiel y legible, la cadena de pensamiento oculta le permite a OpenAI «leer la mente» del modelo y comprender su proceso de pensamiento. Por ejemplo, en el futuro OpenAI podría querer controlar la cadena de pensamiento en busca de indicios de manipulación del usuario. Sin embargo, para que esto funcione, el modelo debe tener libertad para expresar sus pensamientos de forma inalterada, por lo que no se puede entrenar ningún cumplimiento de políticas o preferencias del usuario en la cadena de pensamiento. Tampoco se quiere que una cadena de pensamiento no alineada sea directamente visible para los usuarios.

Por lo tanto, después de sopesar múltiples factores, incluyendo la experiencia del usuario, la ventaja competitiva y la opción de continuar con el seguimiento de la cadena de pensamiento, OpenAI ha decidido no mostrar las cadenas de pensamiento en bruto a los usuarios. Esta decisión tiene desventajas. Y OpenAI se esforza por compensarlo parcialmente enseñando al modelo a reproducir cualquier idea útil de la cadena de pensamiento en la respuesta. Para la serie de modelos o1 se muestra un resumen de la cadena de pensamiento generado por el modelo.

Representación gráfica del funcionamiento de OpenAI o1

Ejemplos de uso de OpenAI o1

El famoso Strawberry está aquí. OpenAI ha publicado varios vídeos de cómo funciona OpenAI o1 en su canal de YouTube. Comparto los más interesantes para mi.

Codificación de videojuegos con OpenAI o1

Matemáticas con OpenAI o1

Razonamiento con OpenAI o1

Contando con OpenAI o1

Serpiente HTML con OpenAI o1

Seguridad de OpenAI o1

Como parte del desarrollo de estos nuevos modelos, se ha ideado un nuevo enfoque de formación en seguridad que aprovecha sus capacidades de razonamiento para hacer que se adhieran a las directrices de seguridad y alineación. Al ser capaces de razonar sobre las normas de seguridad en contexto, pueden aplicarlas con mayor eficacia.

Una forma de medir la seguridad consiste en comprobar hasta qué punto el modelo sigue respetando las normas de seguridad si un usuario intenta saltárselas (lo que se conoce como «jailbreaking»). En una de las pruebas más duras de jailbreaking, GPT-4o obtuvo una puntuación de 22 (en una escala de 0 a 100), mientras que el modelo o1-preview obtuvo una puntuación de 84.

Para estar a la altura de las nuevas capacidades de estos modelos, se ha reforzado el trabajo en materia de seguridad, gobernanza interna y colaboración con el gobierno. Esto incluye pruebas y evaluaciones rigurosas utilizando el Marco de Preparación, el mejor equipo rojo de su clase y procesos de revisión a nivel directivo, incluido el Comité de Seguridad y Protección de OpenAI.

Para avanzar en el compromiso con la seguridad de la IA, recientemente OpenAI ha formalizado acuerdos con los Institutos de Seguridad de la IA de EE.UU. y el Reino Unido.

A quién va dirigido OpenAI o1

Estas capacidades de razonamiento mejoradas pueden ser especialmente útiles si te enfrentas a problemas complejos en ciencia, codificación, matemáticas y campos similares. Por ejemplo, o1 puede ser utilizado por investigadores sanitarios para anotar datos de secuenciación celular, por físicos para generar complicadas fórmulas matemáticas necesarias para la óptica cuántica y por desarrolladores de todos los campos para construir y ejecutar flujos de trabajo de varios pasos.

o1 supone un avance significativo en el estado del arte del razonamiento de IA. Está previsto publicar versiones mejoradas de este modelo a medida que se siga iterando. OpenAI espera que estas nuevas capacidades de razonamiento mejoren su capacidad para adaptar los modelos a los valores y principios humanos. Ellos creen que o1, y sus sucesores, abrirán muchas nuevas posibilidades de uso de la inteligencia artificial en la ciencia, la codificación, las matemáticas y otros campos relacionados.

Información basada en las publicaciones de OpenAI de presentación de o1: «Introducing OpenAI o1-preview«, «Learning to Reason with LLMs» y «Introducing OpenAI o1«.