Datos, privacidad y seguridad para Azure OpenAI

Azure OpenAI y la privacidad de los datos es un tema sobre el que nos están preguntando cada vez que una conversación versa sobre OpenAI y el servicio de Azure.

Esto es un spoiler del post pero para que todo el mundo lo tenga claro: Los datos de entrenamiento proporcionados por el cliente solo se utilizan para afinar el modelo del cliente y no se utilizan por Microsoft para entrenar o mejorar cualquier modelo de Azure OpenAI. El modelo del cliente es del cliente y sólo el cliente tiene acceso a ello.

Datos, privacidad y seguridad del servicio Azure OpenAI

Azure OpenAI almacena y procesa datos para prestar el servicio, supervisar el uso abusivo y desarrollar y mejorar la calidad de los sistemas de IA Responsable de Azure.

Azure OpenAI se ha diseñado teniendo en cuenta el cumplimiento, la privacidad y la seguridad; sin embargo, el cliente es responsable de su uso y de la implementación de esta tecnología.

¿Qué datos procesa el servicio Azure OpenAI?

Azure OpenAI procesa los siguientes tipos de datos:

- Peticiones de texto, consultas y respuestas enviadas por el usuario a través de las operaciones de finalización, búsqueda e incrustación.

- Datos de entrenamiento y validación. Puede proporcionar sus propios datos de entrenamiento consistentes en pares de preguntas y respuestas con el fin de ajustar un modelo de OpenAI.

- Datos de resultados del proceso de entrenamiento. Después de entrenar un modelo ajustado, el servicio generará metadatos sobre el trabajo que incluyen los tokens procesados y las puntuaciones de validación en cada paso.

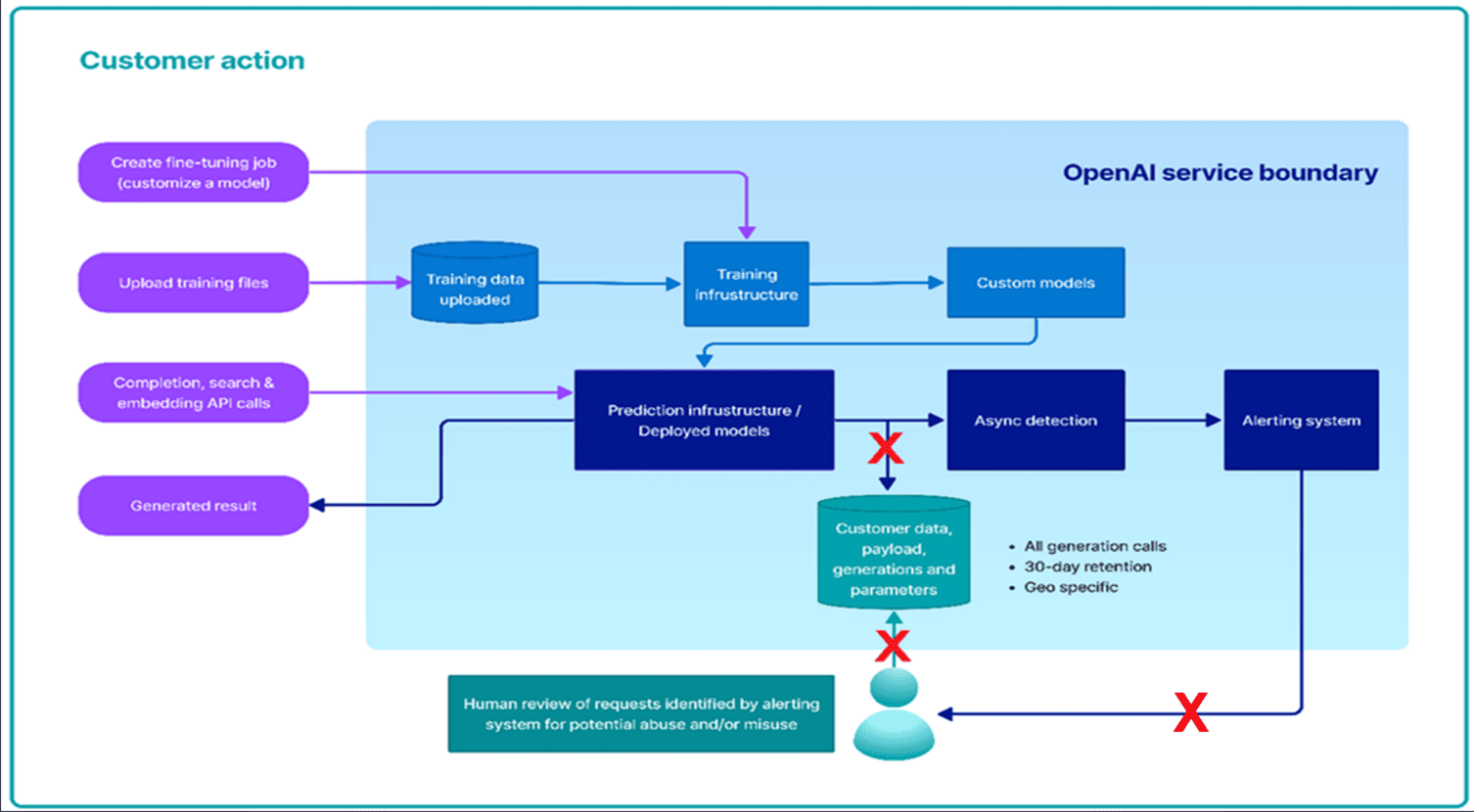

¿Cómo procesa los datos el servicio Azure OpenAI?

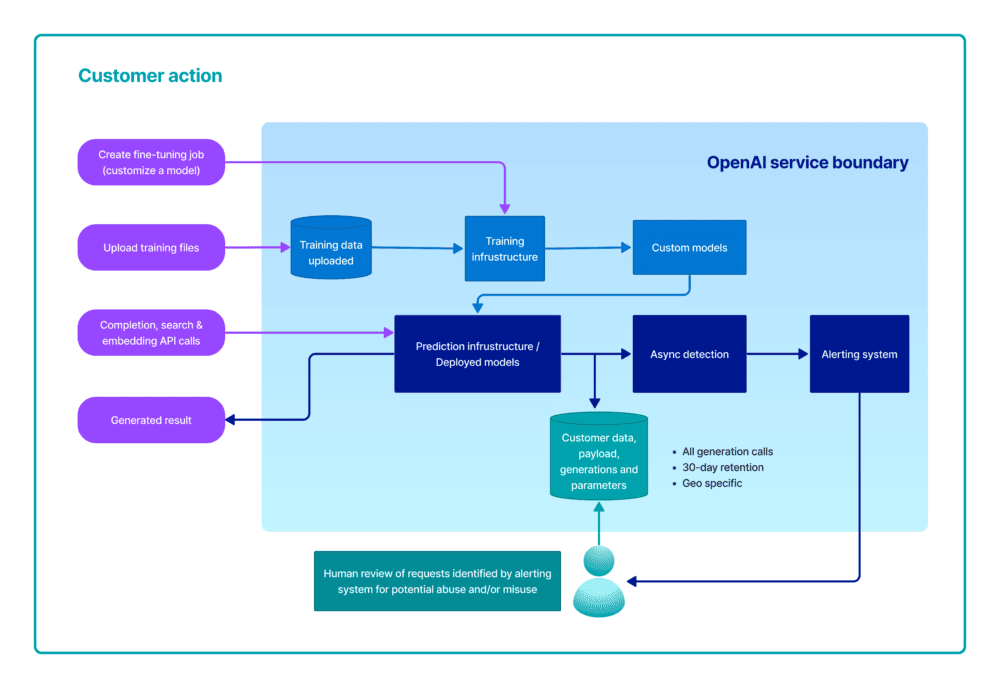

El siguiente diagrama ilustra cómo se procesan sus datos. Este diagrama cubre tres tipos diferentes de procesamiento:

- Cómo el Servicio Azure OpenAI crea un modelo ajustado (personalizado) con sus datos de entrenamiento.

- Cómo el servicio Azure OpenAI procesa sus mensajes de texto para generar complementos, incrustaciones y resultados de búsqueda; y

- Cómo el servicio Azure OpenAI y el personal de Microsoft analizan las instrucciones y los complementos para detectar abusos, usos indebidos o generación de contenido dañino.

Datos de entrenamiento para el ajuste fino de un modelo OpenAI

Los datos de entrenamiento (pares pregunta-completado) enviados a la API de Fine-tunes a través de Azure OpenAI Studio se preprocesan utilizando herramientas automatizadas para la comprobación de la calidad, incluida la comprobación del formato de los datos. A continuación, los datos de entrenamiento se importan al componente de entrenamiento del modelo en la plataforma Azure OpenAI. Durante el proceso de entrenamiento, los datos de entrenamiento se descomponen en lotes y se utilizan para modificar los pesos de los modelos OpenAI.

Los datos de entrenamiento proporcionados por el cliente sólo se utilizan para afinar el modelo del cliente y no son utilizados por Microsoft para entrenar o mejorar ningún modelo de Microsoft.

Abuso y generación de contenido dañino

El servicio Azure OpenAI almacena solicitudes & ejecuciones del servicio para monitorizar el uso abusivo y desarrollar y mejorar la calidad de los sistemas de gestión de contenidos de Azure OpenAI.

Los empleados autorizados de Microsoft pueden acceder a sus datos de solicitud y ejecuciones que hayan activado nuestros sistemas automatizados con el fin de investigar y verificar posibles abusos; en el caso de los clientes que hayan implementado el servicio Azure OpenAI en la Unión Europea, los empleados autorizados de Microsoft estarán ubicados en la Unión Europea. Estos datos pueden utilizarse para mejorar nuestros sistemas de gestión de contenidos.

En caso de que se confirme una infracción de la política, podemos pedirle que tome medidas inmediatas para solucionar el problema y evitar nuevos abusos. Si no se soluciona el problema, se puede suspender o cancelar el acceso a los recursos de Azure OpenAI.

Sistema de administración de contenido

Azure OpenAI Service incluye un sistema de administración de contenido que funciona junto con los modelos centrales para filtrar el contenido. Este sistema funciona ejecutando tanto la solicitud de entrada como el contenido generado a través de un conjunto de modelos de clasificación destinados a detectar el mal uso. Si el sistema identifica contenido nocivo, recibirá un error en la llamada a la API si el mensaje se considera inapropiado.

Para asegurarte de que ha mitigado adecuadamente los riesgos en su aplicación, debes evaluar cuidadosamente todos los daños potenciales, seguir las orientaciones de nota sobre transparencia y agregar la mitigación específica del escenario según sea necesario.

¿Cómo se conservan los datos y de qué controles dispone el cliente?

- Datos de entrenamiento, validación y resultados de entrenamiento. La API de archivos permite a los clientes cargar sus datos de entrenamiento con el fin de ajustar un modelo. Estos datos se almacenan en Azure Storage, cifrados en reposo mediante claves gestionadas por Microsoft, dentro de la misma región que el recurso y aislados lógicamente con su suscripción a Azure y sus credenciales de API. El usuario puede eliminar los archivos cargados mediante la operación DELETE de la API.

- Modelos OpenAI ajustados. La API Fine-tunes permite a los clientes crear su propia versión ajustada de los modelos OpenAI basándose en los datos de entrenamiento que ha cargado en el servicio a través de las API de archivos. Los modelos entrenados y ajustados se almacenan en Azure Storage en la misma región, encriptados en reposo y aislados lógicamente con su suscripción Azure y credenciales API. El usuario puede eliminar los modelos ajustados llamando a la operación DELETE de la API.

- Peticiones, consultas y respuestas de texto. El servicio Azure OpenAI puede almacenar temporalmente los datos de solicitudes y respuestas durante un máximo de 30 días. Estos datos están encriptados y sólo son accesibles a los ingenieros autorizados para (1) propósitos de depuración en caso de fallo, (2) investigar patrones de abuso y mal uso o (3) mejorar el sistema de filtrado de contenidos mediante el uso de los prompts y compleciones marcados por abuso o mal uso.

Preguntas frecuentes sobre Azure OpenAI

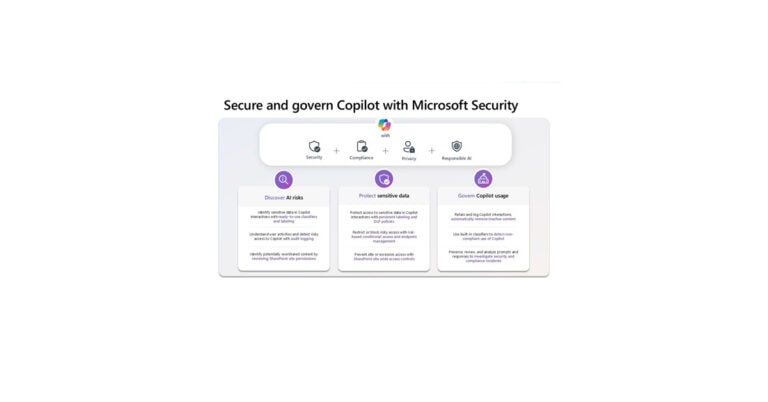

Algunos clientes de sectores muy regulados con casos de uso de bajo riesgo procesan datos confidenciales con menor probabilidad de uso indebido. Debido a la naturaleza de los datos o del caso de uso, estos clientes no desean o no tienen derecho a permitir que Microsoft procese dichos datos para la detección de abusos debido a sus políticas internas o a la normativa legal aplicable.

Para capacitar a tus clientes empresariales y lograr un equilibrio entre las necesidades normativas/de privacidad y la prevención de abusos, el servicio Azure Open AI incluirá un conjunto de funciones de acceso limitado para ofrecer a los clientes potenciales la opción de modificar lo siguiente: supervisión de abusos y filtrado de contenidos.

Estas características de Acceso Limitado permitirán a los clientes potenciales optar por no participar en los procesos de revisión humana y registro de datos sujetos a criterios de elegibilidad regidos por el marco de Acceso Limitado de Microsoft. Los clientes que cumplan los criterios de acceso limitado de Microsoft y tengan un caso de uso de bajo riesgo pueden solicitar la posibilidad de excluirse tanto del registro de datos como del proceso de revisión humana. Esto permite a los clientes de confianza con escenarios de bajo riesgo los controles de datos y privacidad que requieren, al tiempo que nos permite ofrecer modelos AOAI a todos los demás clientes de una manera que minimiza el riesgo de daño y abuso.

Si Microsoft aprueba la solicitud de un cliente para acceder a las funciones de Acceso Limitado con capacidad para (i) modificar la supervisión de abusos y (ii) modificar el filtrado de contenidos, Microsoft no almacenará la solicitud ni la respuesta asociadas. Dado que en este caso no se almacenarán datos de solicitud o respuesta en reposo en el Almacén de Resultados de Servicio, el proceso de revisión humana ya no será viable. Por lo tanto, tanto CMK como Lockbox se considerarán fuera del alcance de la detección de daños y abusos.