Azure AI Foundry: La evolución de Azure AI Studio

Azure AI Foundry es la plataforma todo en uno de Microsoft, diseñada para simplificar el desarrollo, despliegue y gestión de aplicaciones de IA.

Azure AI Foundry es la plataforma todo en uno de Microsoft, diseñada para simplificar el desarrollo, despliegue y gestión de aplicaciones de IA.

La segunda edición del GLOBAL AI Bootcamp Valencia se celebrará el 8 de marzo de 2025 en las instalaciones de Nextraining.

El 28 de febrero y 1 de marzo se celebro el evento de Global AI Community Spain en Madrid.

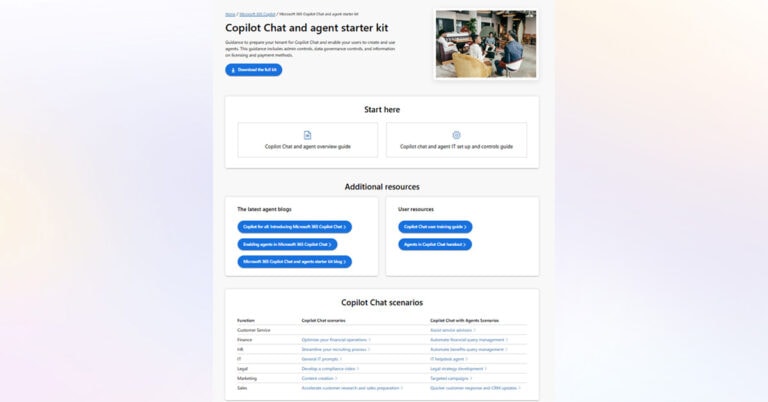

El uso de agentes en Microsoft 365 Copilot Chat por parte de usuarios sin licencia de Copilot para M365 consume mensajes de Copilot Studio.

La combinación de agentes y Microsoft 365 Copilot Chat democratizará la inteligencia artificial generativa en todas las organizaciones.

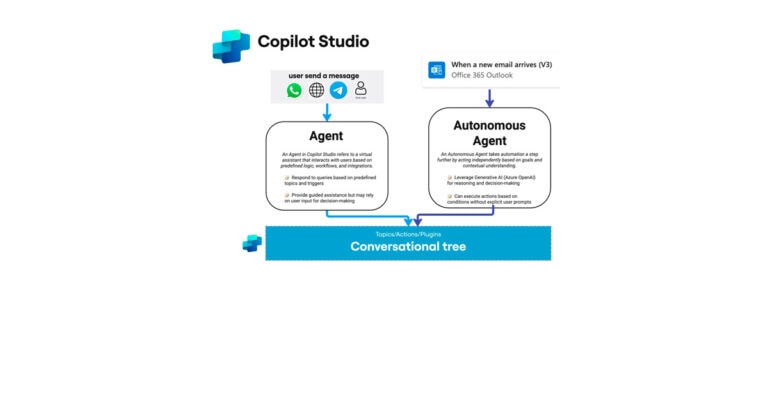

¿Cuál es la diferencia entre un agente y un agente autónomo en Copilot Studio? Te lo explico en este breve post.